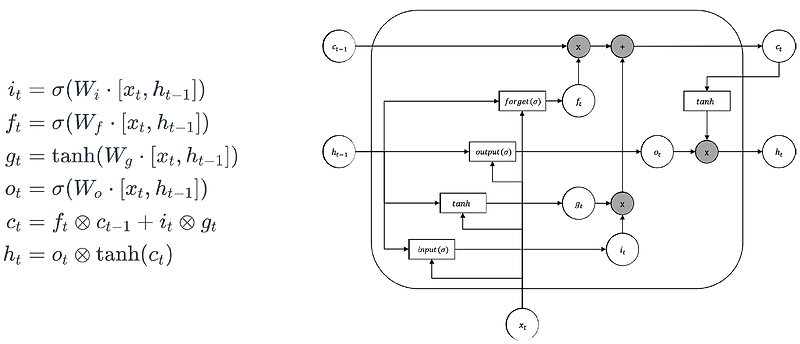

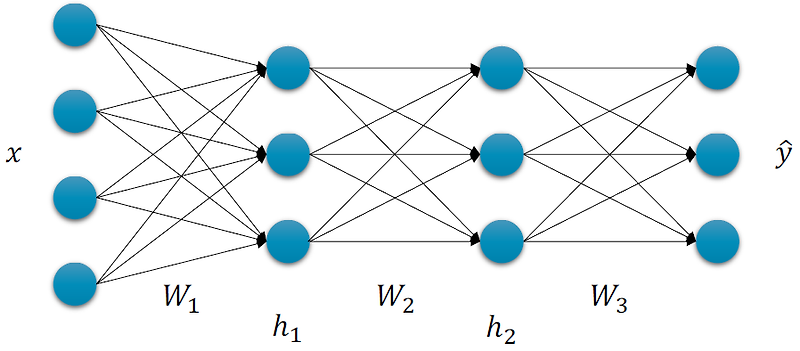

지난 시간에 RNN을 배워보았습니다. RNN의 경우 Gradient Vanishing 문제가 발생했죠. 이유는 출력할 때 hyperbolic Tangent(하이퍼볼릭 탄젠트, tanh)으로 Back Propagation을 할 때 문제가 생기죠. Back Propa..

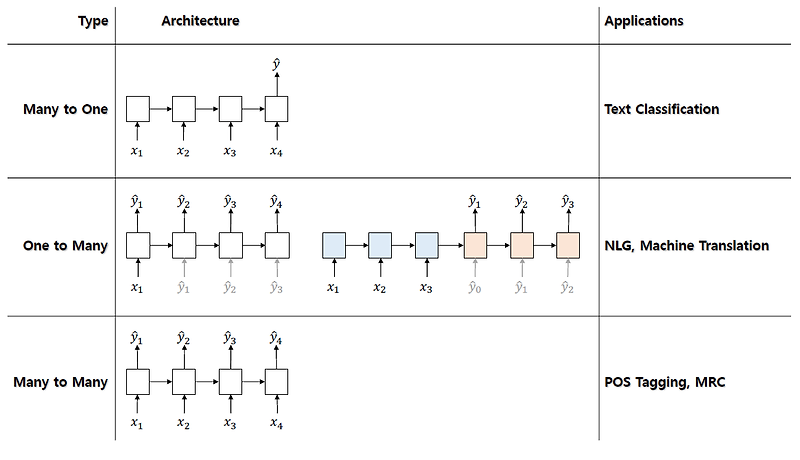

RNN의 Gradient 문제 해결하기 위한 기법? LSTM(Long Short Term Memory)와 GRU(Gated Recurrent Unit)이란?에 대한 요약내용입니다.

자세한 내용은 아래에 원문링크를 확인해주시기 바랍니다.

원문링크 : RNN의 Gradient 문제 해결하기 위한 기법? LSTM(Long Short Term Memory)와 GRU(Gated Recurrent Unit)이란?

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티