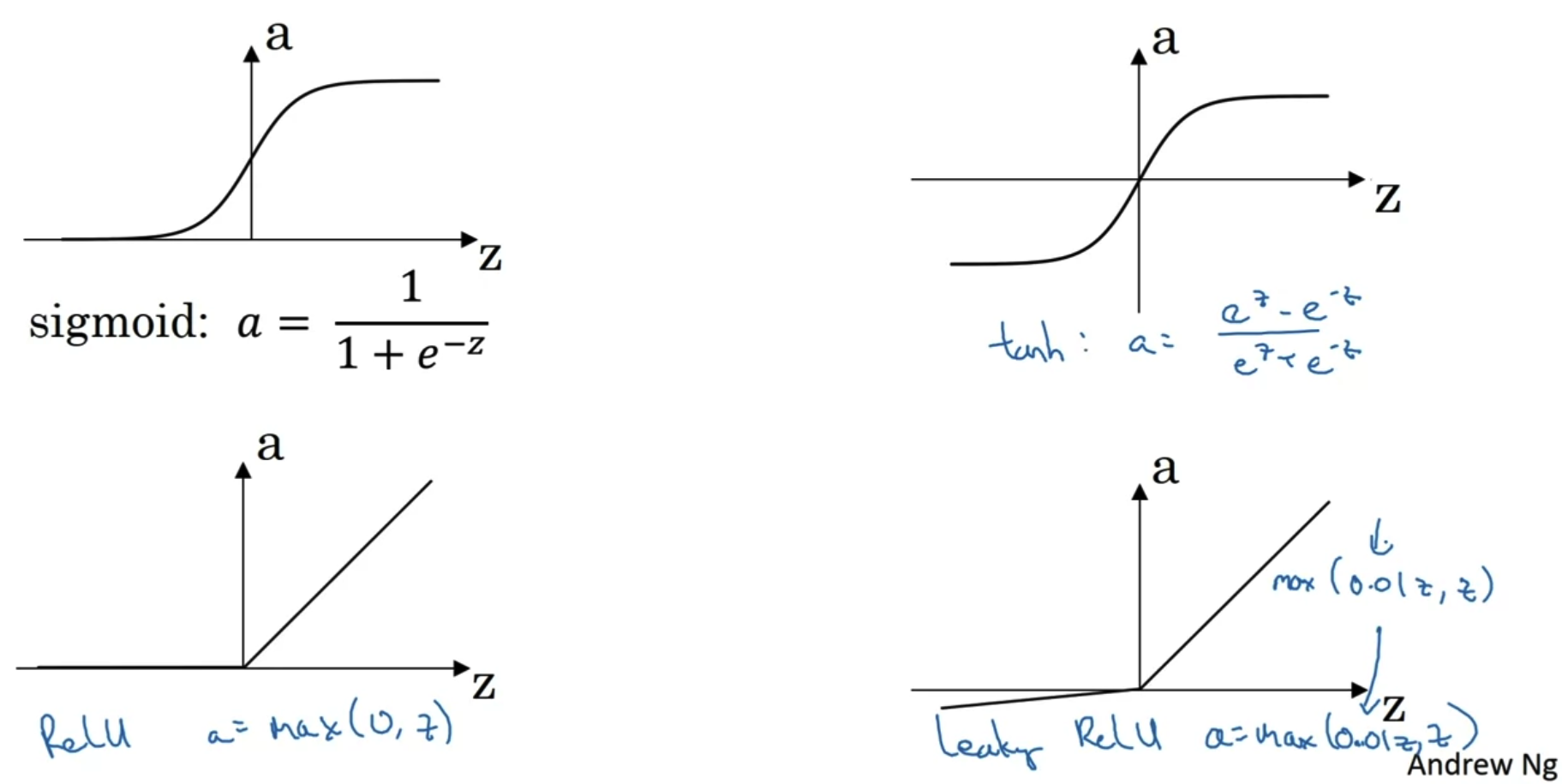

1. Activation Functions 이제는 activation function으로 sigmoid를 사용하지 않는다. 거의 모든 경우에 대해서 tan h를 activation function으로 사용하는 것이 더 좋기 때문이다. tan h는 sigmoid와 달리 non-linear한 내용에도 적용될 수 있다. 단, output layer의 activation function으로 sigmoid를 사용하는 것이 tan h를 사용하는 것보다 편리한 경우가 예외로 존재한다. 이때는 y(label)이 0 또는 1로 구분되는 이진분류인 경우인데, y hat의 범위가 -1에서 1인 것보다 0에서 1로 나오는 것이 더 좋기 때문이다. 따라서 hidden layer의 activation function은 sigmo..

원문링크 : Shallow Neural Network(2)

![<Retrieval> [DSI] Transformer Memory as a Differentiable Search Index (2022.02) <Retrieval> [DSI] Transformer Memory as a Differentiable Search Index (2022.02)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbwxZjL%2FbtsAs7vzXIv%2FcZzO6B9p9MmLeQSeuhjwuk%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티