![[Short Paper Review] Distilling Step-by-Step! Outperforming Larger Language Models with Less Training Data and Smaller Model Sizes [Short Paper Review] Distilling Step-by-Step! Outperforming Larger Language Models with Less Training Data and Smaller Model Sizes](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FBtPHA%2Fbtsgn2BNAgG%2FkA95GS8RW4DoyGuiTm3MG0%2Fimg.png)

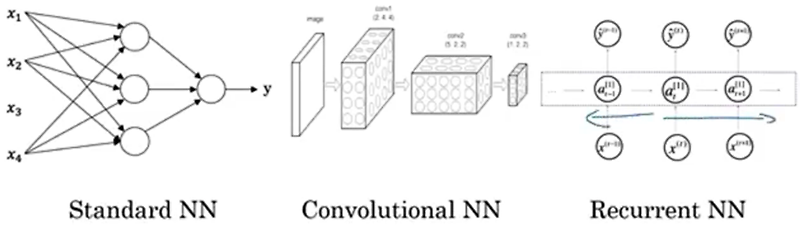

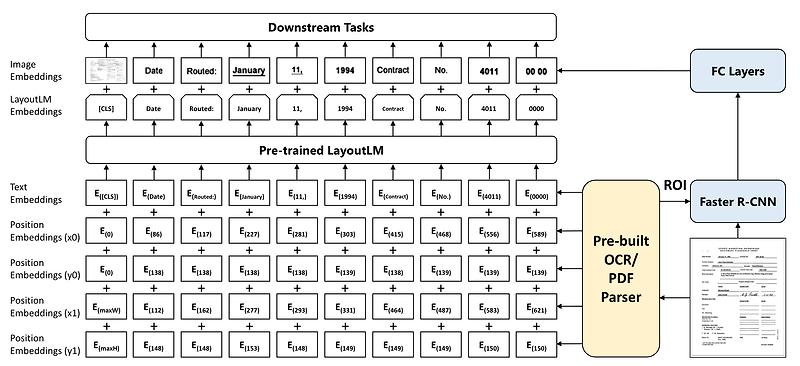

최근에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success 단순히 추론 결과가 아닌 그에 대한 설명(rationale)을 학습하여 엄청나게 적은 자원과 작은 모델로 훌륭한 퍼포먼스를 내는 distillation 기법 배경 LLM의 훌륭한 능력을 이용하는 방법은 크게 finetuning, distillation 두 가지로 나눠집니다. 그러나 finetuning은 전체 파라미터를 학습해야 하기 때문에 computing 자원을 많이 필요로 하고, distillation은 unlabeled data가 많이 필요하며 특정 task에 대해서만 학습이 가능하다는 문제점이 존재합니다. 이러한 문제점을 해결하기 위해 ‘적은..

![[BOJ] 5430 : AC [구현/덱](Python) [BOJ] 5430 : AC [구현/덱](Python)](http://t1.daumcdn.net/tistory_admin/static/images/openGraph/opengraph.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티