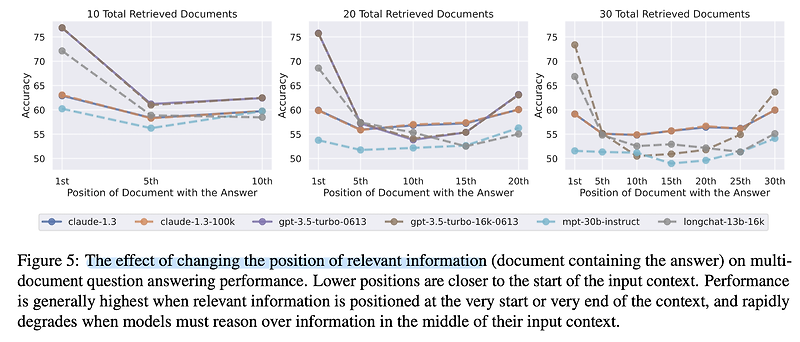

최근(2023.07)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [Standford University] multi-document QA와 key-value retireval에서, query와 관련된 정보가 context의 시작, 또는 끝에 위치하는 것이 유리하다. 이 경향은 context가 길어질수록 명확해지기 때문에, context의 길이를 x축으로 삼고 모델 성능을 y축으로 삼는 그래프는 U자 curve로 그려진다. 배경 최근 LLM을 언급하면 빠질 수 없는 이야기는 처리 가능한 입력 길이입니다. 이를 늘리기 위해서 다양한 연구가 이뤄지고 있는데, 실제로 참조해야 할 문서가 많아질수록 모델의..

원문링크 : <LLM> Lost in the Middle: How Language Models Use Long Contexts

![<KD, Hallucination> [Idk Dataset] Can AI Assistants Know What They Don't Know? (2024.01) <KD, Hallucination> [Idk Dataset] Can AI Assistants Know What They Don't Know? (2024.01)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fdw35oV%2FbtsD7otV29C%2FtIYAgsqvAmLqeK25SkOaxk%2Fimg.png)

![[프로그래머스] 덧칠하기 (Python) [프로그래머스] 덧칠하기 (Python)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FclI9nR%2Fbtsfeh06Idz%2FSfeYKP9EKTQKtftSNVKFtK%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티