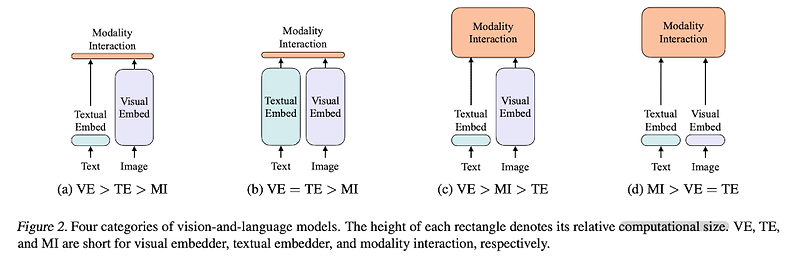

예전(2021.02)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ 이미지 feature 추출에서 놓치게 되는 효율성/속도, 그리고 표현력을 보완하기 위한 방법으로 Vision-and-Language Transformer (ViLT) 모델을 고안. image에 patch 개념을 활용하여 연산량을 획기적으로 줄일 수 있었음 배경 현재 대중(?)에게 가장 많이 사용되는 멀티모달 모델 중 하나인 ViLT입니다. 인공지능 모델이 서로 다른 두 modality의 정보를 이해하기 위해서는 각각의 feature embedding을 합치는 과정이 필요합니다. 즉 이미지 feature와 텍스트 feature를 적절히 조합하는 것이 중요한 것이죠. 그런데 이미..

원문링크 : <Multi-modal> ViLT: Vision-and-Language Transformer Without Convolution or Region Supervision

![[프로그래머스] 공원 산책 (Python) [프로그래머스] 공원 산책 (Python)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Ft1.daumcdn.net%2Ftistory_admin%2Fstatic%2Fimages%2FopenGraph%2Fopengraph.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티