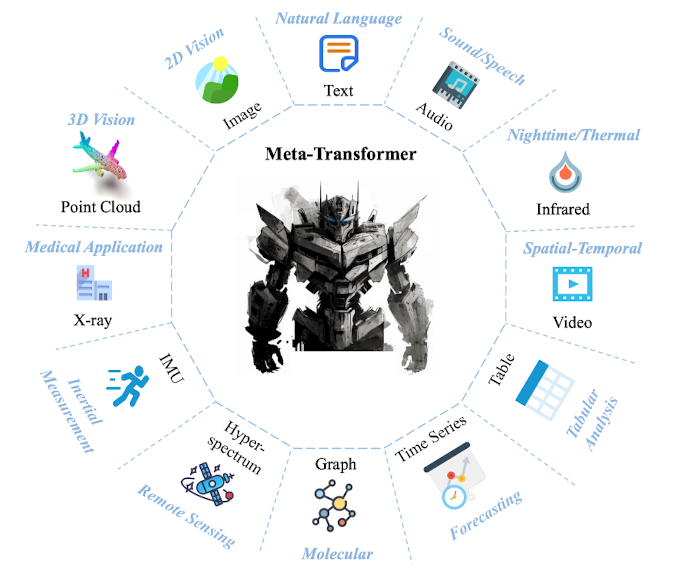

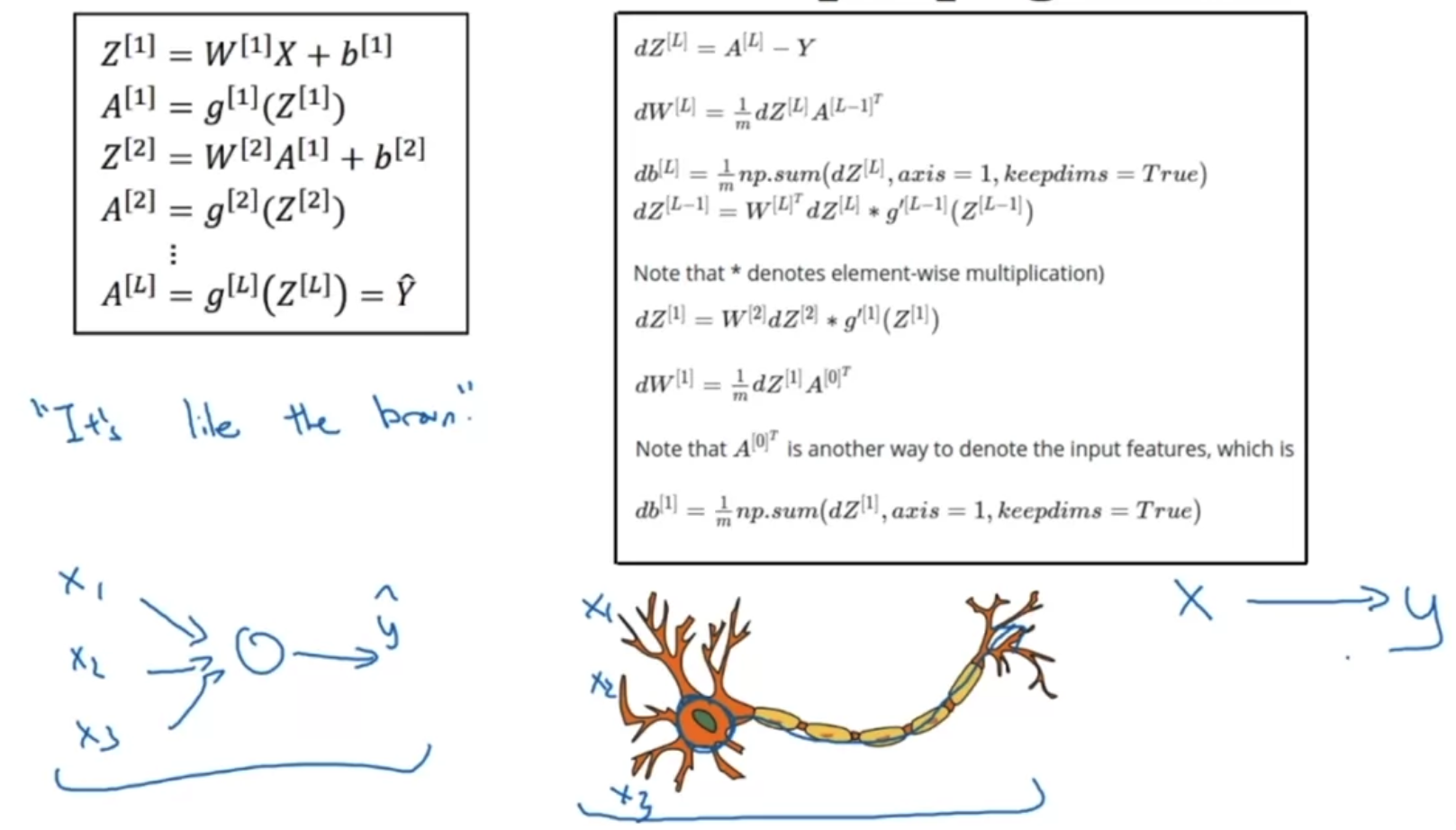

최근(2023.07)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success multimodal 전용의 pair data 없이 frozen encoder로 feature를 추출하여, 12개의 modality에 대해 동시에 이해할 수 있는 transformer 기반 모델, Meta-Transformer 배경 마치 인간의 뇌처럼, 인공지능 모델도 한 modality에서 얻은 지식을 다른 곳으로 전이할 수 있도록 하는 연구가 이어지고 있습니다. 하지만 근본적으로 다른 modality 데이터는 그 특징과 성질이 너무 다르기 때문에 쉽지 않은 문제죠. 그래서 지금까지는 대부분 image - text 수준을 벗어나는 연..

원문링크 : <Multi-modal> Meta-Transformer: A Unified Framework for Multimodal Learning

![[Short Paper Review] LLaMA-Adapter V2: Parameter-Efficient Visual Instruction Model [Short Paper Review] LLaMA-Adapter V2: Parameter-Efficient Visual Instruction Model](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fk6d5J%2FbtsedcZLWef%2FkvuLcqQvuAlE7L2DnsO2Xk%2Fimg.png)

![[프로그래머스] 덧칠하기 (Python) [프로그래머스] 덧칠하기 (Python)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FclI9nR%2Fbtsfeh06Idz%2FSfeYKP9EKTQKtftSNVKFtK%2Fimg.png)

![[BOJ] 1107 : 리모컨 [브루트포스](Python) [BOJ] 1107 : 리모컨 [브루트포스](Python)](http://t1.daumcdn.net/tistory_admin/static/images/openGraph/opengraph.png)

![<LK Lab, Instruction> [Flipped Learning] Guess the Instructoin! Flipped Learning Makes Language Models Stronger Zero-Shot Learners (2023.06) <LK Lab, Instruction> [Flipped Learning] Guess the Instructoin! Flipped Learning Makes Language Models Stronger Zero-Shot Learners (2023.06)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fb4On3G%2FbtsAkvwDwWU%2FLJOiJFbWt7rlCsZ5NN6sqK%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티