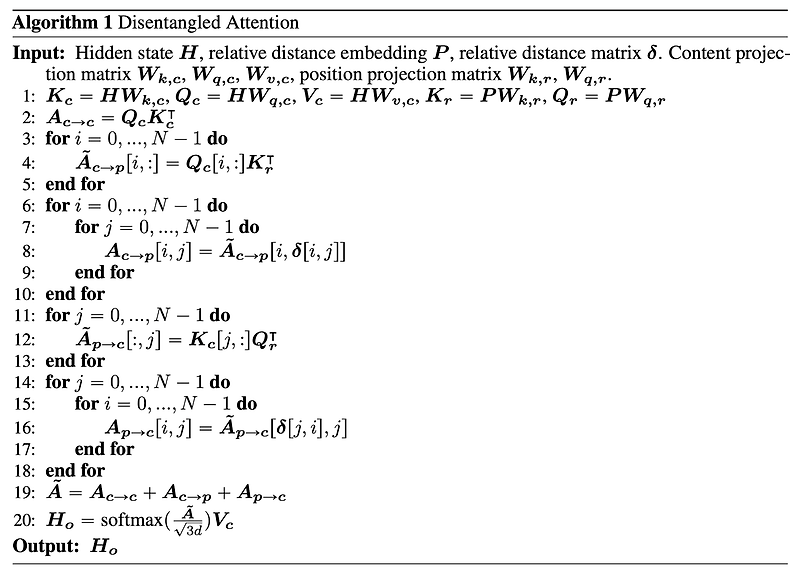

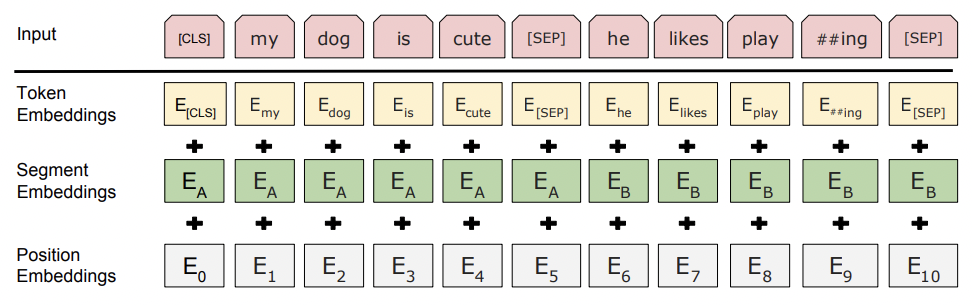

과거(2020.06)에 나온 논문을 읽어보고 간단히 정리했습니다. 캐글 프로젝트를 하면서 이 모델에 대해 공부를 한 번 하고 싶어서 빠르게 읽고 간단히 정리한 내용입니다! (버전 3가 올해에 나와 있어서 그것도 얼른 공부를 해야 될 것 같네요) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [Microsoft Research] disentangled attention mechanism과 enhanced mask decoder라는 새로운 기법을 적용. 기존 BERT 및 RoBERTa 모델의 단점을 개선한 새로운 architecture, DeBERTa를 제시. 배경 당시(2020년도)에는 self-attention을 기반으로 한 여러 모델들이 쏟아..

원문링크 : <LM> DeBERTa: Decoding-enhanced BERT with Disentangled Attention

![<LLM> [Short Paper Review] Can large language models provide useful feedback... <LLM> [Short Paper Review] Can large language models provide useful feedback...](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbDyDqh%2FbtsxkCt1qQI%2FgCDaT5pOGxjmKgvZkKBLr1%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티