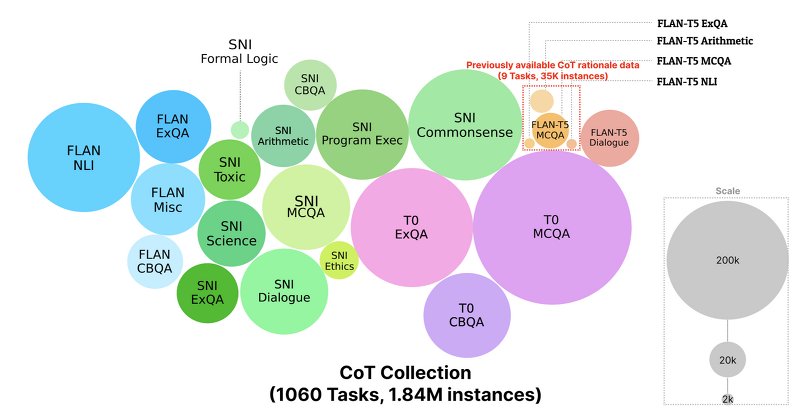

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ [KAIST] - new instruction-tuning dataset, CoT Collection - 1.84 million rationales across 1,060 tasks - 100B 이하 사이즈의 LM을 CoT Collection으로 instruction tuning하여, 4개의 domain-specific tasks에 대해 강한 few-shot learning 성능을 보임 배경 Chain-of-Thought (CoT) prompting을 이용하여 LM이 여러 태스크에서 훌륭한 성능을 보일 수 있도록 만..

![<DB, Agent> [FunSearch] Mathematical discoveries from program search with largelanguage models (2023.12) <DB, Agent> [FunSearch] Mathematical discoveries from program search with largelanguage models (2023.12)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FTZBOI%2FbtsCLq1DTDG%2FJQEB6dX3OKsgalHZzBuuo0%2Fimg.png)

![<Retrieval> [GenRead] Generate rather than Retrieval: Large Language Models are Strong Context Generators (2023.01) <Retrieval> [GenRead] Generate rather than Retrieval: Large Language Models are Strong Context Generators (2023.01)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FAAGYt%2FbtsAmrCR0cB%2FwpShyLzke3kv7ckChkCyX1%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티