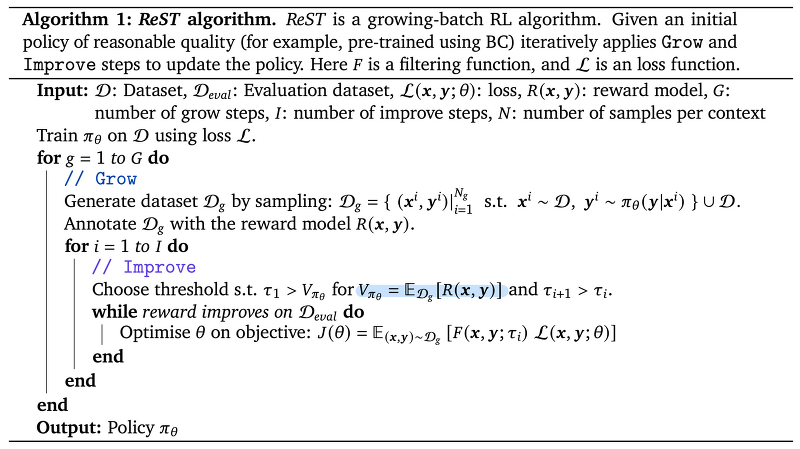

관심있는 NLP 논문을 읽어보고 ChatGPT를 이용하여 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [Google DeepMind, Google Research] Abstract 주요 내용: 이 논문은 인간의 선호도에 맞춰 대규모 언어 모델(Large Language Model, LLM)의 출력 품질을 향상시키기 위해 인간 피드백으로부터의 강화학습(Reinforcement Learning from Human Feedback, RLHF) 방법을 제안합니다. 제안하는 알고리즘의 이름은 Reinforced Self-Training (ReST)이며, 이는 강화학습(Reinforcement Learning, RL)의 성장 배치 방식에 ..

원문링크 : <RLHF> Reinforced Self-Training (ReST) for Language Modeling (2023.08)

![[프로그래머스] 두 원 사이의 정수 (Python) [프로그래머스] 두 원 사이의 정수 (Python)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Ft1.daumcdn.net%2Ftistory_admin%2Fstatic%2Fimages%2FopenGraph%2Fopengraph.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티