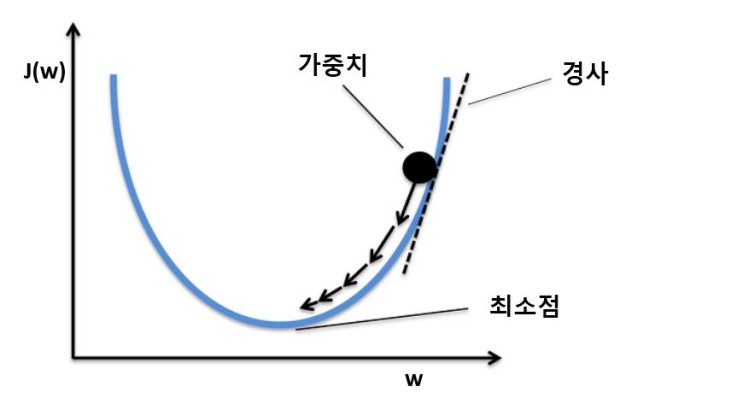

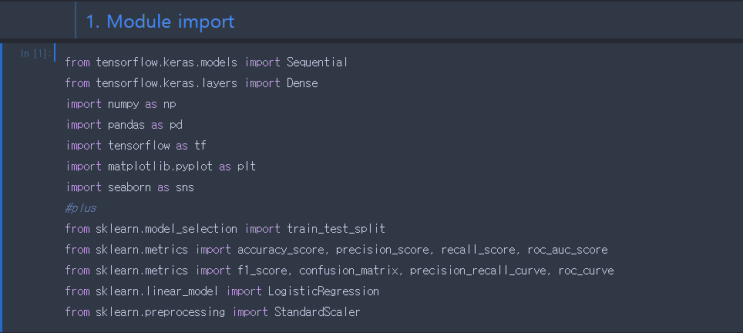

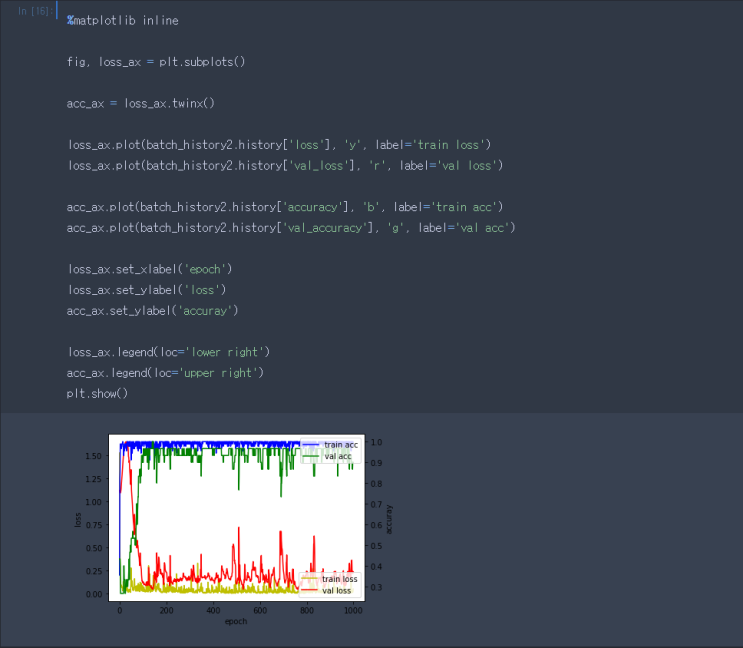

경사 하강법 그림 경사하강법은 학습률과 손실함수의 순간 기울기를 이용하여 가중치1를 업데이트하는 방법입니다. 경사의 지점에서 미분 기울기를 이용하여 오차를 비교하고 최소화하는 방향으로 이동시키는데 이때 오차를 구하는데 사용하는 것이 손실함수입니다. 가중치1 : 입력 값이 연산 결과에 미치는 영향력을 조절하는 요소 경사하강법은 손실 함수의 비용이 최소가 되는 지점까지 기울기가 낮은 쪽으로 계속 이동시키는 과정을 반복하는데, 이 과정에서 성능이 나빠지거나 시간이 오래 소요되는 문제가 발생합니다. 이러한 문제들을 해결하기 위한 개선책으로는 배치 경사 하강법, 확률적 경사 하강법, 미니 배치 경사 하강법이 있습니다. BGD 배치 경사 하강법 (Batch Gradient Descent, BGD) 전체 데이터셋에 대한 오류를 구한 후 기울기를 계산하여 모델의 파라미터를 업데이트하는 방법입니다. 전체 훈련 데이터셋에 대한 가중치를 편미분하기 때문에 학습이 오래 걸리는 단점이 있습니다. SGD 확...

#AI

#가중치

#경사하강법

#딥러닝

#머신러닝

#배치경사하강법

#손실함수

#인공지능

#프로그래밍

원문링크 : 2. 경사 하강법 (Gradient Descent)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티