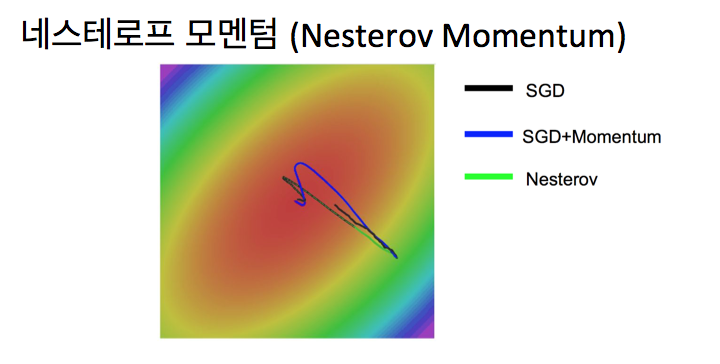

옵티마이저는 데이터와 손실 함수를 바탕으로 모델의 업데이트 방법을 결정하고 학습을 안정적으로 만들고 속도를 빠르게 해줍니다. 확률적 경사 하강법의 파라미터 변경 폭이 불안정한 문제 등을 해결하는데 사용되는 옵티마이저에 대해 경사하강법 파생 모델들 위주로 알아보겠습니다. 확률적 경사 하강법 (SGD, Stochastic Gradient Descent) 모멘텀과 네스테로프 모멘텀, 학습률 감소 기법을 지원하는 경사 하강법입니다. ※자세한 설명은 경사 하강법 포스트를 참고. keras.optimizers.SGD(lr=0.01, momentum=0.0, decay=0.0, nesterov=False) <파라미터> · lr: 0보다 크거나 같은 float 값. 학습률. · momentum: 0보다 크거나 같은 float 값. SGD를 적절한 방향으로 가속화하며, 흔들림(진동)을 줄여주는 매개변수입니다. · decay: 0보다 크거나 같은 float 값. 업데이트마다 적용되는 학습률의 감소율입...

#AI

#옵티마이저

#아담

#아다그라드

#모멘텀

#머신러닝

#딥러닝

#네스테로프

#경사하강법

#인공지능

원문링크 : 3. SGD와 옵티마이저 (Optimizer)

![[에러 해결] 파라미터 갯수 에러](https://blogimgs.pstatic.net/nblog/mylog/post/og_default_image_160610.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티