![[머신러닝] PCA (Principal Component Analysis) 주성분 분석 선형회귀 차이, 주성분 개수 구하기 [머신러닝] PCA (Principal Component Analysis) 주성분 분석 선형회귀 차이, 주성분 개수 구하기](https://mblogthumb-phinf.pstatic.net/MjAyMTAxMjJfNTQg/MDAxNjExMjkzOTM5NDU3.VpN3UI24158Po0m_XdxBcDM1AUkGf-tEcMEYrvSVICgg.dTYqGPfq7Axn4J40-z3YCeITWgtOqVDvZfybIgopto4g.PNG.dbwjd516/coursera_machine_learning.png?type=w2)

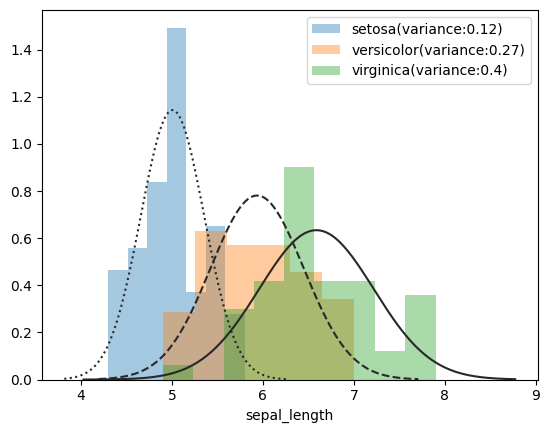

머신러닝 / 딥러닝 기초를 다지고자 coursera에서 Adrew Ng 교수가 진행하는 머신러닝 강의를 수강하게 되었다. 다음은 Dimensionality Reduction 강의 내용을 정리한 것이다. Data Compression 데이터 압축 Feature dimension(데이터 차원)이 쓸데 없이 너무 높아 중복성(redundancy)가 큰 경우, dimension을 줄일 수 있다. 상관관계가 높은 feature를 찾고 그래프를 그려서 두 feature을 동시에 대표할 수 있는 새로운 line을 찾아내는 방법을 쓸 수 있다. Dimensionality reduction(차원 축소)으로 컴퓨터 메모리에 저장되는 데이터 양을 줄이고, 알고리즘 학습 속도를 높일 수 있다. *Dimensionality reduction이란 feature의 개수를 줄이는 것이지 example의 수를 줄이는 것이 아니다. 즉, m은 같은 크기이며, 각 example의 feature 수 n이 줄어드는 것이...

#coursera

#코세라

#주성분분석

#주성분

#이웃환영

#비지도학습

#머신러닝

#대학생

#공부블로그

#개수구하기

#PCA

#통계학과

원문링크 : [머신러닝] PCA (Principal Component Analysis) 주성분 분석 선형회귀 차이, 주성분 개수 구하기

![[Python] 백준 실버3 19941번 햄버거 분배 (그리디)](https://mblogthumb-phinf.pstatic.net/MjAyNDAzMTRfMyAg/MDAxNzEwMzk1ODc4NjU5.DT1vWjHCRUQ-G-dfiPE6mlWuQSqeBTp6lynm_6IdkEsg.EKCG8VTRxaKfLbSthGJn_FEFIhJhuHk1Qrlv5sGzoI0g.PNG/image.png?type=w2)

![[공모전] 2022 빅콘테스트 : 앱 사용성 데이터를 통한 대출신청 예측분석](https://mblogthumb-phinf.pstatic.net/MjAyMjEyMjBfMjE3/MDAxNjcxNTI2OTI2MTQ3.TvfqGXp12qN6gIWuV7A_QGvX_e_fodIhuN63aKyp-bIg._5owkk46JSeoE9_oJng4nlyq1MVZT8DPNbRL1mnbD2sg.JPEG.dbwjd516/%B5%A5%C0%CC%C5%CD%BA%D0%BC%AE%B8%AE%B1%D7_%C7%BB%C3%C4%BD%BA%BA%CE%B9%AE_%C5%EB%B0%E8%B1%DD%C2%CA%C0%CC%B5%E9_%B0%E1%B0%FA%BA%B8%B0%ED%BC%AD.jpg?type=w2)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티