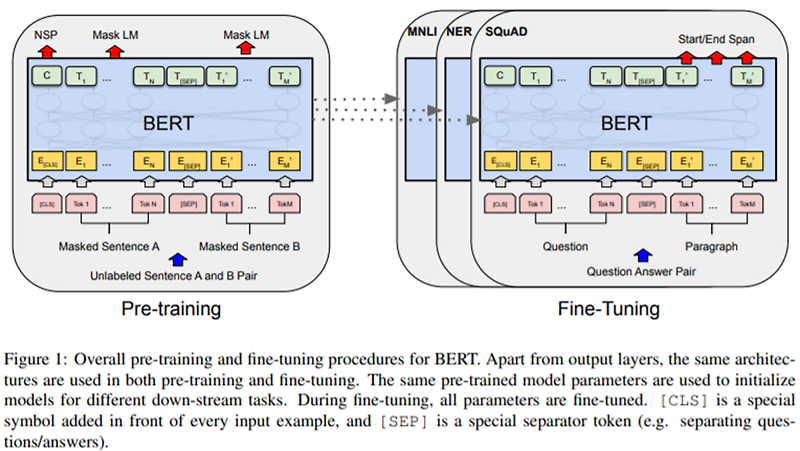

Abstract 이번 연구팀에서는 새로운 language representation 모델인 BERT에 대해 소개한다. 이 BERT는, Bidirectional Encoder Representations from Transformers를 의미한다. 최근의 language representation..

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding에 대한 요약내용입니다.

자세한 내용은 아래에 원문링크를 확인해주시기 바랍니다.

원문링크 : BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

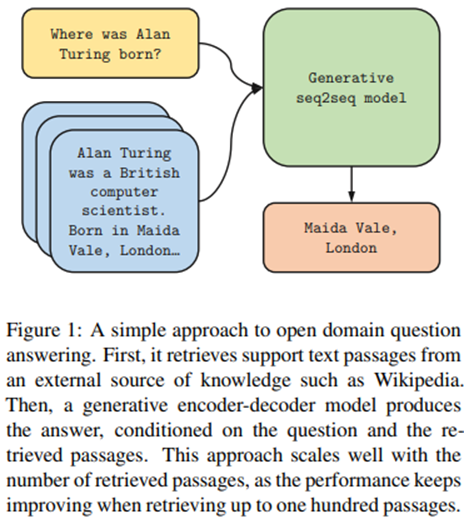

![[MRC] 03. Generation-based MRC [MRC] 03. Generation-based MRC](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fbr9ukq%2FbtrAwF8QRMS%2FeiCBbKgQY4OjUPAfFpUVf1%2Fimg.png)

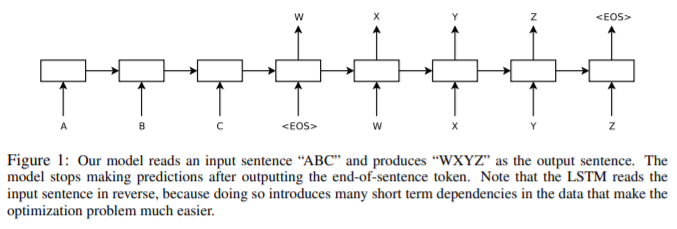

![[MRC] 02. Extraction-based MRC [MRC] 02. Extraction-based MRC](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fcng0ta%2FbtrAvHrVn8R%2F4mry2881OLsF7OTKmiwGRk%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티