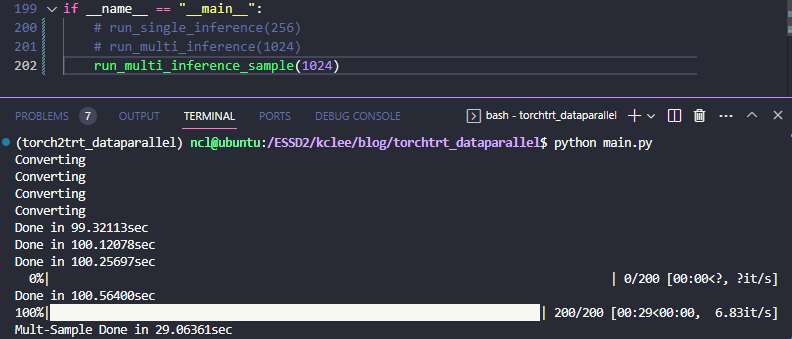

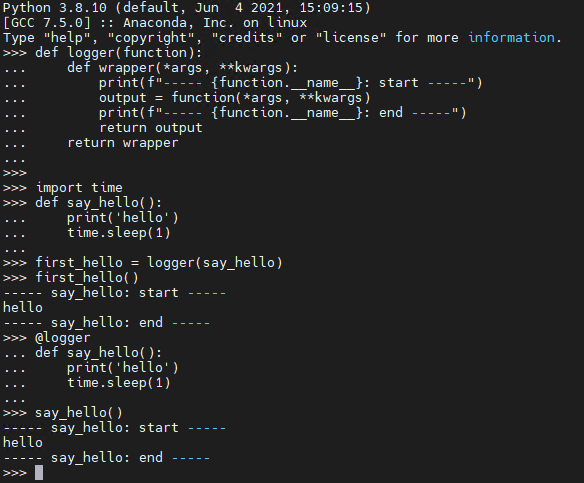

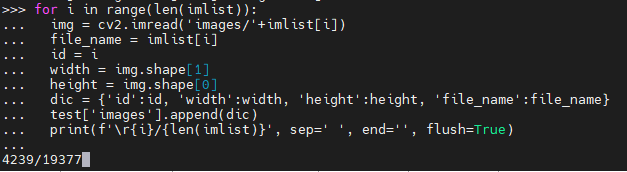

준비물 : Anaconda, Pytorch, torch2trt, GPU(본 포스팅에서는 3080*4ea) TL;DR → 필자 깃허브의 torchtrt_dataparallel 준비단계 먼저, 아나콘다를 통해서 아래와 같이 환경 설정을 수행한 후 본 포스팅을 시작하면 되겠다. 최종적인 환경도 깃허브(링크)에 yml 파일로 올려두었으니 그걸로 바로 설치해도 무방하다. conda create -n torch2trt_dataparallel python=3.8 conda activate torch2trt_dataparallel 그 다음 파이토치를 아래와 같이 설치하고(지금은 2.0 이 stable 버전이지만, torch2trt 호환도 그렇고 필자는 쫄보라서 1.11.0 설치한다. 2.0을 시도해 보는것도 권장한다)..

원문링크 : Pytorch-TensorRT Dataparallel Inference 직접 만들기

![[KAIST한정]전문연구요원 출퇴근 관리 텔레그램 봇을 만들어보자(1) [KAIST한정]전문연구요원 출퇴근 관리 텔레그램 봇을 만들어보자(1)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FVq1nM%2FbtsCF6Qmpsb%2FT3ZV6uD42k0cDKQRyDb110%2Fimg.webp)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티