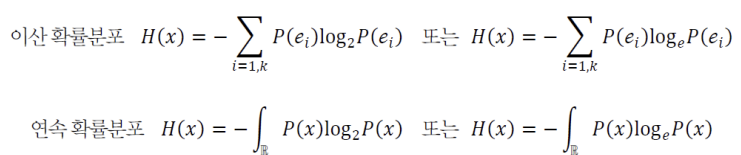

정보이론 1) 메시지가 지닌 정보를 수량화할 수 있나? “고비 사막에 눈이 왔다”와 “대관령에 눈이 왔다”라는 두 메시지 중 어느 것이 더 많은 정보를 가지나? 정보이론의 기본 원리 -> 확률이 작을수록 많은 정보 2) 자기 정보self information 사건(메시지) ℯcc의 정보량 (단위: 비트 또는 나츠) 3) 엔트로피 확률변수 x의 불확실성을 나타내는 엔트로피 4) 자기 정보와 엔트로피 예제 주사위가 윷보다 엔트로피가 높은 이유는? 확률이 균일할수록(= 확률이 다 같을수록) 엔트로피가 크다. 5) 교차 엔트로피cross entropy 두 확률분포 P와 Q 사이의 교차 엔트로피 식을 전개하면, 6) 예시 최적화 1) 순수 수학 최적화와 기계 학습 최적화의 차이 기계 학습의 최적화는 단지 훈련집합이 주어지고, 훈련집합에 따라 정해지는 목적함수의 최저점을 찾아야 함 • 데이터로 미분하는 과정 필요 -> 오류 역전파 알고리즘 (딥러닝) • 주로 SGD(스토캐스틱 경사 하강법) 사...

원문링크 : 3-2주차: 기계학습 기초수학

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티