![[DNN] 배치 정규화 Batch Normalization [DNN] 배치 정규화 Batch Normalization](https://mblogthumb-phinf.pstatic.net/MjAyMTA3MDlfMTgz/MDAxNjI1ODMxMjUwMjAw.Ru4N9bMEH1qiKiic_5rvvj0pAf8avcC6rVGw9-4QFLQg.AHSNRVSl6IwRdiP1SW6bCR0oIHk7RxEn8jvX05zVcmgg.JPEG.fbfbf1/%B3%EB%C6%AE90_0.jpg?type=w2)

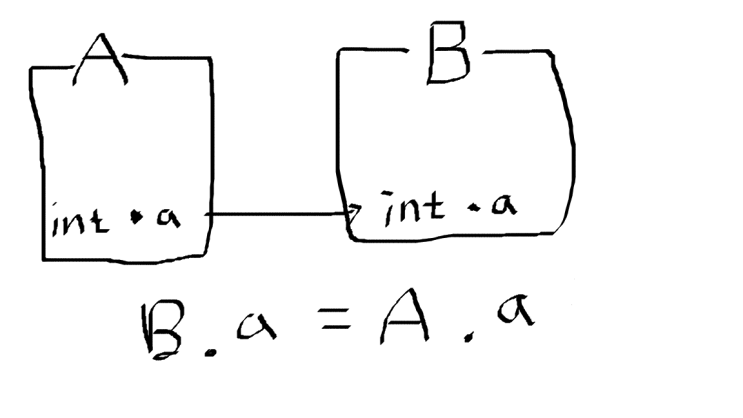

밑바닥부터 시작하는 딥러닝 책을 보고 혼자 정리한 내용입니다. 가중치의 초깃값을 적절히 설정하면 각 층의 활성화 값 분포가 적당히 퍼지면서 학습이 원활하게 수행된다. 그럼 각 층이 활성화를 적당히 퍼뜨리도록 강제해보면 어떨까? 배치 정규화가 이런 아이디에서 출발했다. 배치 정규화 배치 정규화의 장점은 1. 학습을 빨리 진행할 수 있다.(학습 속도 개선) 2. 초깃값에 크게 의존하지 않는다.(초깃값 선택 부담감 감소) 3. 오버피팅을 억제한다.(드롭아웃 등의 필요성 감소) 배치 정규화의 기본 아이디어는 각 층에서의 활성화값이 적당히 분포되도록 조정하는 것이다. 아래 그림과 같이 데이터 분포를 정규화하는 배치 정규화(Batch N..........

[DNN] 배치 정규화 Batch Normalization에 대한 요약내용입니다.

자세한 내용은 아래에 원문링크를 확인해주시기 바랍니다.

원문링크 : [DNN] 배치 정규화 Batch Normalization

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티