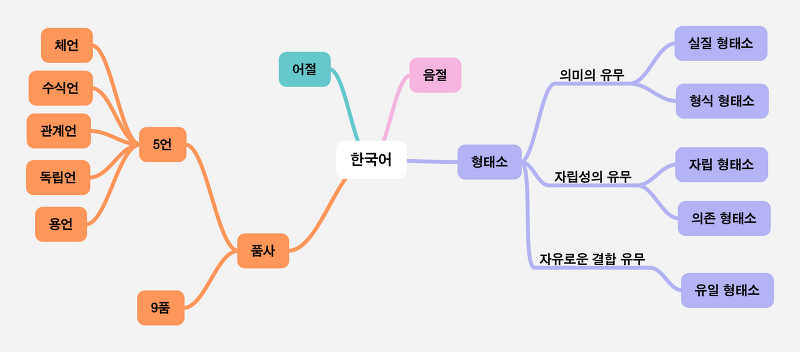

NLP에서의 Tokenization NLP에서의 Tokenization은, 두 개 이상의 다른 token의 결합으로 이루어진 단어를 쪼개어, 단어의 숫자를 줄이고 희소성(sparseness)를 낮추기 위해 실행된다. 단어의 숫자를 줄이고 희소성을 낮춘다는 것은 과연 무슨 뜻일까? 다음 예제를 같이 살펴보자 희소성을 줄여주는 Tokenization "배가 너무 고프다 저녁밥 뭐 먹어야하지" "배는 별로 고프지 않아" 위와같은 두 개의 문장이 있다. 직관적으로 봤을 때, 여기서의 "배" 부분과 "고프다" 부분은 같은 의미이다. 하지만, 컴퓨터는 "배가"와 "배는" , "고픈데" 와 "고프지"를 다른 단어로 인식한다. 따라서, 같은 의미이지만 각각의 단어로 인식되는 것이다. 그만큼 희소성도 올라가게 된다. 그..

원문링크 : Tokenization(토큰화)란 무엇일까?

![[논문 리뷰] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks [논문 리뷰] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fcu77eM%2FbtscQaJ0rOg%2FoCvPXGa1z6vuqfZrs7fvTK%2Fimg.png)

![[알고리즘] 정렬 알고리즘(Sorting algorithm) (1) [알고리즘] 정렬 알고리즘(Sorting algorithm) (1)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbKsLwh%2FbtrHsEWmQUC%2FnSqYAkMw1QPLETMNKBHOcK%2Fimg.png)

![[자료구조] 해시 테이블(Hash Table)이란? [자료구조] 해시 테이블(Hash Table)이란?](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FdJzqov%2FbtrJ7SLMqsJ%2FfKOcnBBNCKezQ3mwOuZ4Dk%2Fimg.jpg)

![[JavaScript] npm 살펴보기 [JavaScript] npm 살펴보기](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Ft1.daumcdn.net%2Ftistory_admin%2Fstatic%2Fimages%2FopenGraph%2Fopengraph.png)

![[논문 리뷰] Language Models are Unsupervised Multitask Learners - GPT-2 [논문 리뷰] Language Models are Unsupervised Multitask Learners - GPT-2](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fb7bwNL%2FbtrT4QQtP0K%2FoGRwNN8DhcyhvT8P98WfC1%2Fimg.png)

![[논문 리뷰] Neural Machine Translation by Jointly Learning to Align and Translate - Bahdanau Attention [논문 리뷰] Neural Machine Translation by Jointly Learning to Align and Translate - Bahdanau Attention](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FAms1H%2FbtrSKuVeg6Z%2FcoMuo26iQdCJo84POyKrrK%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티