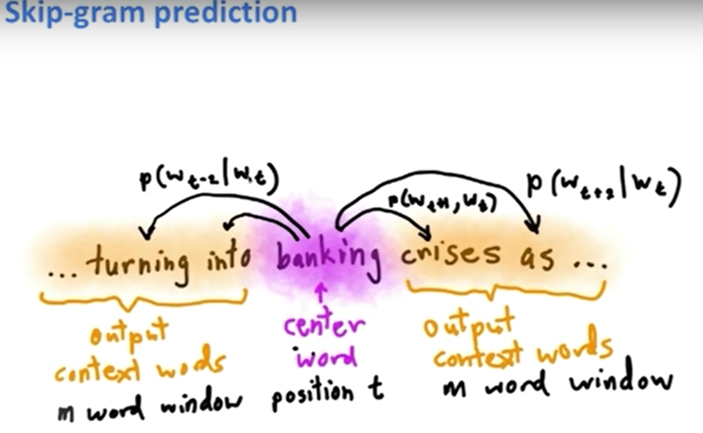

Context. 이산적(discrete)으로 표현된 문장은 뉘앙스가 없어서 본래의 의미와 조금 다르게 해석될 수 있다. -One-hot vector 벡터에 0이 있는 것. -One-hot Vector의 문제점 만약 motel이 [ 0 0 0 0 0 0 0 0 1]이고 hotel이 [0 1 0 0 0 0 0 0 0] 이라면 두 단어는 유사함에도 불구하고 내적 했을때 값이 0이된다. 분배 유사성을 이용해야한다. 즉, 어떤 context의 맥락을 예측하고 싶다면 그 단어가 나타났을 때 그 의미를 이해하면 된다. 그 단어들은 각각 양 옆에 단어가 있을 것이다. 그 유사성을 측정하기 위해서 두 벡터 사이의 내적을 계산할 것이다. 단어를 Vector로 바꿔보자. Word2vec Wt는 초점단어. W – t 는 컨텍스트 안에 있는 모든 단어가 포함됨. -Loss function = cost function = Objective function: 현재 중심 단어에서 어떤 문맥의 확률을 최대화한다....

원문링크 : Lecture 2 | Word Vector Representations: word2vec

![[Java] 보행자 천국](https://mblogthumb-phinf.pstatic.net/MjAyMzA4MjZfMjcg/MDAxNjkzMDM1ODM1MDMx.k77sN-hNg3Vj5pu7ZUCIDGMR-2AWYM2fyF0_mytybr0g.jAgxzQMLCF299riUa-NUTBFBYQSVcLakxECsjLeeIpMg.PNG.gkswlcjs2/image.png?type=w2)

![[Java] 최고의 집합](https://mblogthumb-phinf.pstatic.net/MjAyMzA4MjZfMjA1/MDAxNjkzMDE4NTMwMDQy.Bxf6lLvV08JfjJsiw088R4stU9xc1Tpxe0mqY9zsnwcg.-5QOTOXbAc5qtelQmuaPZWX13l3DIWSpbJTyOPNuQyYg.PNG.gkswlcjs2/image.png?type=w2)

![[C++] 백준 11726](https://mblogthumb-phinf.pstatic.net/MjAxOTA4MTVfMjIx/MDAxNTY1ODM5Mjc4ODE2.Z9fepw-_WcDLzNaBBh0deOG7HGTYq_Dwg66OHWjEZc4g.nDmGXKndAgFg9BKLwPySjuXRQdq7qMp-MvgRfaE8Pdsg.PNG.gkswlcjs2/image.png?type=w2)

![[Java] 추석 트래픽](https://mblogthumb-phinf.pstatic.net/MjAyMzA4MjlfMjk0/MDAxNjkzMjU1MTE0Mjky.mDCKd7A33F3Xk6ZBzbZP-Tg4qmYzNHBE76obZZYiK0Mg._1J0dTlezXoirWC1Ts0nBmd6UgHXEqownQgEjrMFzpsg.PNG.gkswlcjs2/image.png?type=w2)

![[Java] 순위](https://mblogthumb-phinf.pstatic.net/MjAyMzA5MTBfMTgy/MDAxNjk0MzQyMjE5NzQw.9b-fXy6A-gnBz9JU-3FTbVt1RmTS5U7qPWrXYasvkJAg.1PfvVroe35gthHHhR_lfqNF_yGkiKXLGl0cN34w1uHMg.PNG.gkswlcjs2/image.png?type=w2)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티