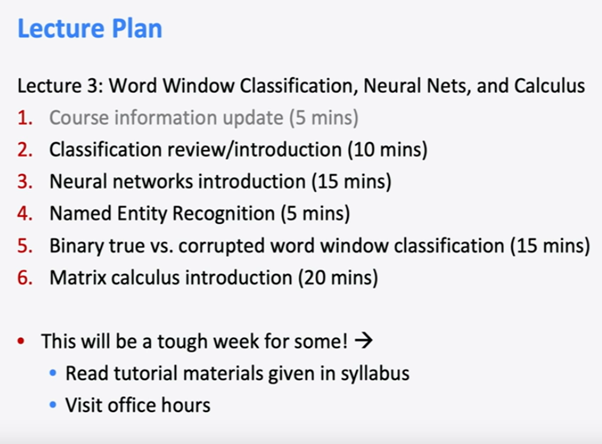

Lecture 3 – Neural Networks 목차 è Softmax를 쓰든지 logistic regression을 쓰든지 상관없다. è 슬라이드에서도 나와있지만, 우리의 목표는 correct class y의 확률을 최대화 하거나, negative 로그확률을 최소화 하는 것이다. è Full dataset에서의 Cross entropy loss function è 우리는 d-차원 가중치의 열벡터를 가진다 왜냐하면 wi와 rd의 내적을 할 것이기 때문에. è 그래서 우리는 c 곱하기 d항목과 W 행렬을 가지고 그것들이 우리 모델의 매개변수가 된다. è 우리가 경사 하강법을 이용해 모델을 학습시키고자 한다면 gradiantW를 사용하고 그것을 바탕으로 loss function을 업데이트 해야한다. è 그렇다면 신경망에서는 분류화가 어떻게 다를까? Naïve Bayes models è High bias classfier라면 단지 하나의 선만 그릴 것이기 때문에 정확하지 못하다. è P...

원문링크 : Lecture 3 – Neural Networks

![[C++] 백준 1966](https://mblogthumb-phinf.pstatic.net/MjAyMjExMTJfMTYg/MDAxNjY4MjIxNTU1Nzc0.UqopYiLjDYhHjH3nrZJocd5-urIyPWu2HtlvdFozGwAg.kmkMtsXC1rKGVlXsHpW-xDD0bD_03-_yZ3G1fI7EZ4Yg.PNG.gkswlcjs2/image.png?type=w2)

![백준 2579 [c++]](https://mblogthumb-phinf.pstatic.net/MjAxOTA4MTJfODcg/MDAxNTY1NTczOTE2OTQ5.FqbdDsIXcH8SKFZELepG054PXdNioOSxAZXN7PGvllYg.jQvruQG5khShNkYWRr6diiHchj_tgmH0V36ESJ_NZlog.PNG.gkswlcjs2/image.png?type=w2)

![[Java] 프로그래머스 가장 큰 수](https://mblogthumb-phinf.pstatic.net/MjAyMzA3MjJfNDYg/MDAxNjg5OTkyMTUyMTQx.FWYP5oZ8jfrx_W5GO6EuXENX482BN108mzVQ7YsIRIog.Qs6PK9k46RuZnvo0fQ4k9imo_kAVJvDdlbAoa3oQt1Ig.PNG.gkswlcjs2/image.png?type=w2)

![[C++] 프로그래머스 네트워크(DFS)](https://mblogthumb-phinf.pstatic.net/MjAyMjExMzBfMTI3/MDAxNjY5NzYwNjMwNzEy.OfTnYvaEPASR5rMaNW3PjGeQZS88u_Tw3-A-vZsoBcAg.VwzUef6epWYSLzfdr8CYMZoYeEg7Q0PLa1IdXtDQ3Xog.PNG.gkswlcjs2/image.png?type=w2)

![[북리뷰] 보다 예배다운 예배를 꿈꾸다](https://mblogthumb-phinf.pstatic.net/MjAyMjA1MDhfOTAg/MDAxNjUyMDEwMTA3MzM0.s2EWNoFdV_9EW1avjoBq9rm9q6kQ6YyDs5aK0XJBV70g.RhvAhGnlG3Fzr3qlzhLyqPrRkJNwBoFaUyvolzjhyyIg.PNG.gkswlcjs2/image.png?type=w2)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티