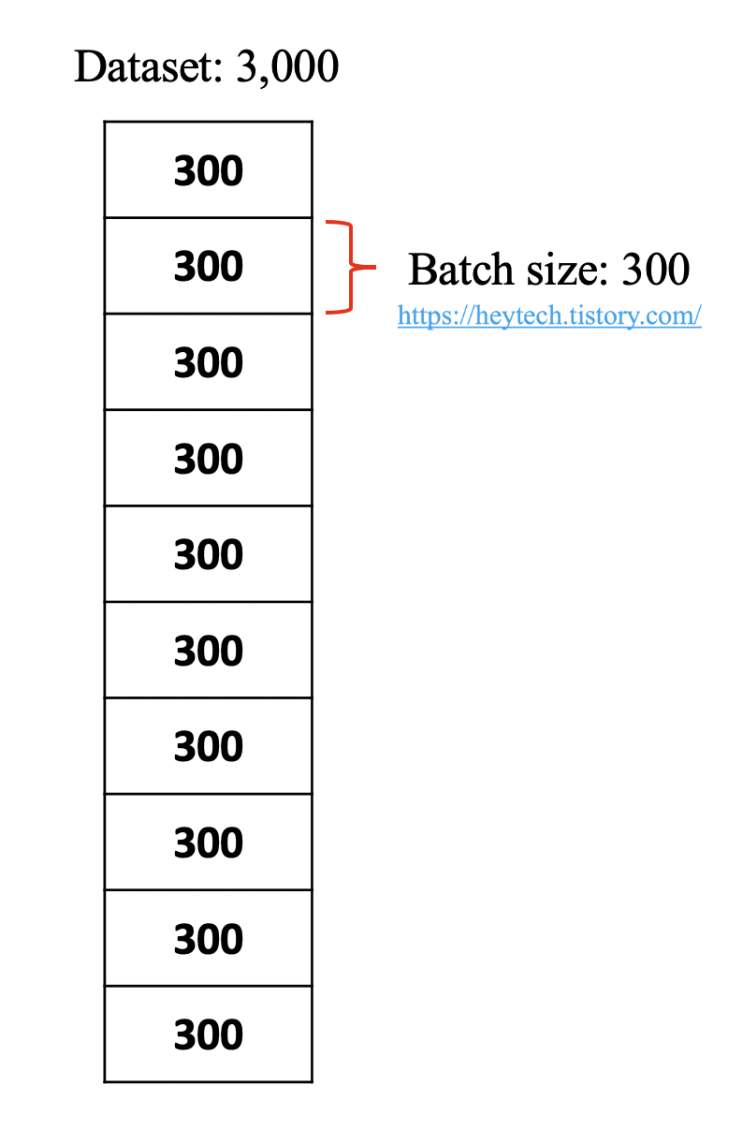

Batch Size Batch 크기는 모델 학습 중 parameter를 업데이트할 때 사용할 데이터 개수를 의미함. 사람이 문제 풀이를 통해 학습해 나가는 과정을 예를 들어보면, Batch 크기는 몇 개의 문제를 한번에 쭉 풀고 채점할지를 결정하는 것과 같음 딥러닝에서 batch는 위 예시같은 역활로 Batch 크기만큼 데이터를 활용해 모델이 예측한 값과 실제 정답 같의 오차(손실함수를 이용)를 계한하여 Optimizer(손실을 최소화 시키면서 경사를 내려가는 방법을 결정하는 알고리즘) 예를들어 총 100개의 문제가 있을때 , 25개씩 풀고 채점한다면 Batch크기는 25임 Batch 예시 Iteration(이터레이션) iteration는 전체 데이터에 대해 총 Batch의 수를 의미함, step이라고 부르기도함 예시로 Batch 크기가 300이고 전체 데이터 개수가 3,000이라면 전체 데이터셋을 학습시키기 위해서는 총 10개의 Batch가 필요함 이때 Iteration의 수는 1...

원문링크 : 딥러닝 Epoch, Iteration, Batch size 개념

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티