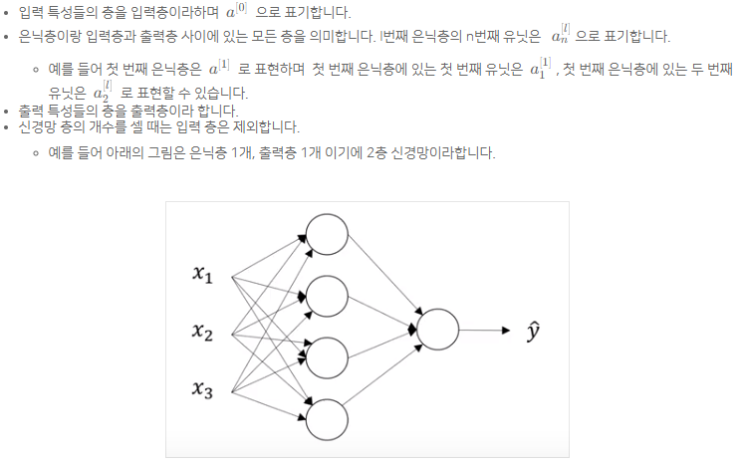

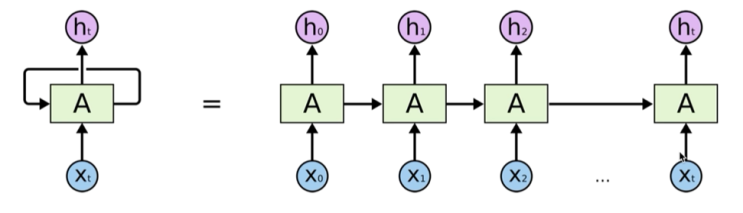

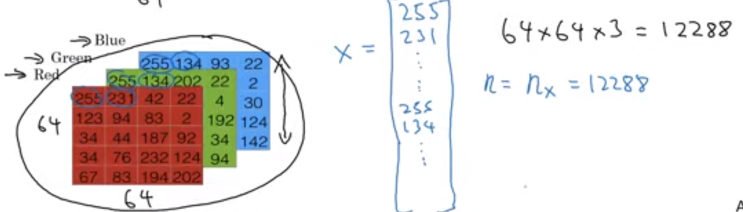

Andrew NG 딥러닝 강의를 듣고 정리합니다. 4. 얕은 신경망 네트워크 input / hidden / output layer for문을 사용하면 비효율적이므로 벡터화를 진행해야한다. Activation functions 활성화 함수에는 아시다시피 많은 종류가 있다. 보통 딥러닝에서는 ReLu 또는 Leaky ReLu 를 많이 사용한다. 대기, 기상분야에서는 tanh도 많이 사용하는 것으로 알고 있다. 데이터에 맞게, 출력값에 맞게 적절하게 상황에 맞게 사용하면 좋다. 이진분류의 출력층에서는 Sigmoid를 사용한다. 혹시 은닉층에서 뭘 써야될지 고민이라면 ReLu를 사용한느 것이 좋습니다. 우선 ReLu는 Sigmoid나 tanh보다 빠르게 학습이 가능하다. 물론 케바케 학습을 느리게 하는 원..........

원문링크 : 딥러닝 1단계: 신경망과 딥러닝(4)

![[2021 마이 블로그 리포트] 블로그 빅데이터로 알아보는 '2021 내 블로그 스타일'](https://mblogthumb-phinf.pstatic.net/MjAyMTEyMDlfMjUx/MDAxNjM5MDM2NTE3MjY5.8IiEk3ff7uZmwzMcJYT5FRxLpEZmjNXkx_Dx5H_bRycg.2-45a9XSvO59vrmhqx_3Ow2Hb8RG0Yvq6eXbGMOIB7Eg.PNG.holeman0406/my_blog_report.png?type=w2)

![[CS231N] Lecture7 : Training Neural Networks II](https://mblogthumb-phinf.pstatic.net/MjAyMDExMjlfMTE5/MDAxNjA2NTc5MzgwNjU0.PjvCFaunqp_NNJW_34Dlrn_yqlQMyiIHmPnQW3xgEH4g.KLOtrxY-QWJ8NbOHhchSBGbrtXBw2jnkzZQ6KXwno6Ug.PNG.holeman0406/image.png?type=w2)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티