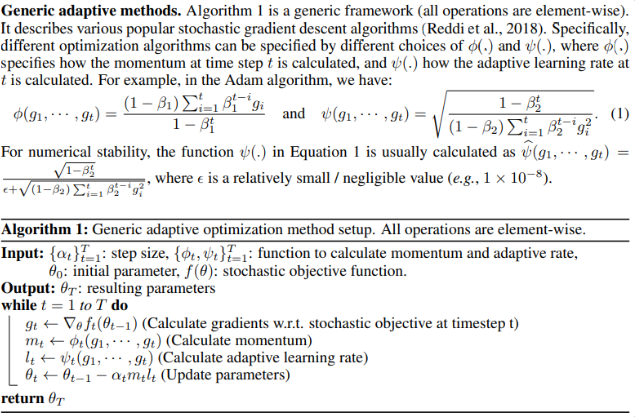

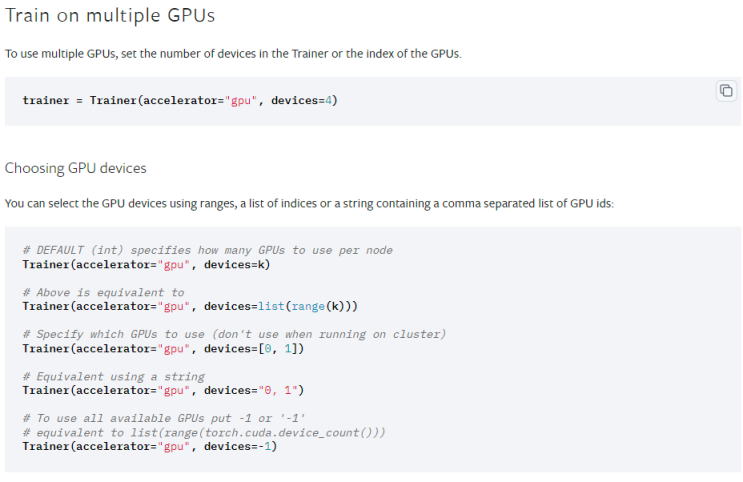

Optimizer RAdam warmup Learning Rate RAdam의 탄생 Optimizer는 계속해서 발전을 거듭하고 있습니다. 하지만 그 중에서도 가장 세상을 흔들었던 Optimizer는 ADam일 것입니다. 따라서 그에대한 후속 연구가 정말 많이도 진행되었는데, RAdam도 그 중에 하나라고 할 수 있을 것 같습니다. 시작은 YOLO에서 RAdam의 성능이 좋은지에 대해서 알아보기 위해 시작되었는데, YOLO에서는 SGD 다음으로 좋은 것 같습니다. Vision 문제 분야에서 Adam의 종류 알고리즘들이 좋은 성능을 보이지 못한다고 합니다. 그 이유중 하나가 올바른 Global Optima로의 수렴 진행이 더디다는 문제인데, 이를 해결해주는 방법이 RAdam 입니다. 해당 글은 YOLO에 적용을 위한 시야로 논문을 살펴보았습니다. 논문의 원 내용과는 차이가 존재할 수 있습니다. 글의 마지막 부분에서는 YOLO에 어떻게 간단하게 적용할 수 있는지 알아봅니다. Summar...

#Adam

#YOLOv5

#YOLO

#SGD

#review

#최적화

#RAdam

#papers

#optimizer

#adamW

#리뷰

#논문리뷰

#AI

#warmup

#torch

#DL

#Learningrate

#LR

#optim

#rate

원문링크 : On the Variance of the Adaptive Learning Rate and Beyond : RAdam

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티