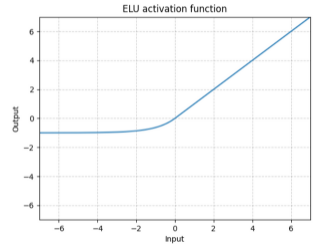

NonLinear는 말그대로 비선형 동작을 하도록 파라미터들에 계산되어지는 값입니다. DeepLearning에서는 모델을 깊게 쌓는 것이 중요한데 이때 각각의 Layer가 non-Linear하지않으면, 반복적으로 쌓는다고 하더라도 한 번의 계산으로 이루어지게 됩니다. 각각의 Layer를 하나의 선형 계산이 이루어지지 않도록 Layer마다 Non-linear를 계산해주어 넘겨주면 각각의 Layer는 다른 결과를 낼 수 있는 파라미터를 가지게 되는 것으로 볼 수 있습니다. 해당 페이지에서는 Torch에 존재하는 Linear들의 그래프를 살펴보고 어떠한 곳에서 이점이 있는지 간략하게 살펴봅니다. 아래 GIF는 많은 Activation Function들의 흐름을 한 눈에 볼 수 있습니다. https://mlfromscratch.com/activation-functions-explained/#/ 1. ELU 그래프 : 등장 이유 : ReLU가 엄청난 성능을 보이는 것은 사실이지만, ReLU는...

#activation

#파이토치

#torch

#threshold

#tanh

#sigmoid

#selu

#rrelu

#relu

#pytorch

#prelu

#nonlinear

#jjunsss

#hardshrink

#gelu

#elu

#activationfunctino

#활성화함수

원문링크 : Pytorch activation Functinon overview

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티