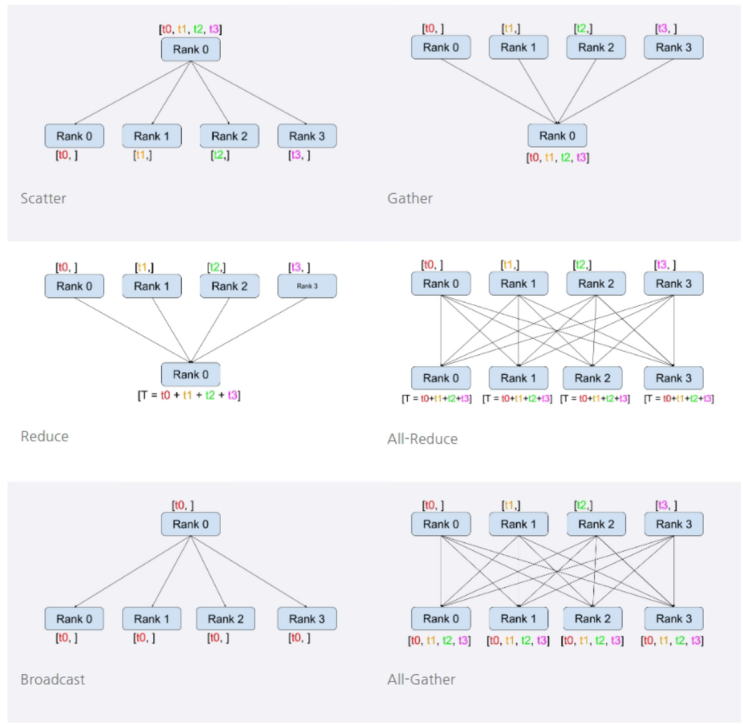

서론 DDP를 사용하다 보면 이를 가지고 다양하게 응용하고 싶어집니다. 하지만 DDP는 싱크가 맞지 않게된다면 알 수 없는 오류를 계속해서 일으킬 뿐더러 해결하기도 정말 어렵게 만들어버립니다. 제가 연구하면서 있었던 여러가지 오류들을 발생하는 요인들을 살펴보고 정리합니다. 참고로 DDP는 웬만해서는 건드리지 않고 훈련하는게 정신건강에 이롭습니다. 해당 글은 DDP의 싱크를 맞추지 않음으로 생기는 문제를 해결하기 위해 사용했던 방법들을 제시합니다. 저는 아래와 같은 방법으로 해결했지만 모델, 데이터 스트림 등등에 따라서 해결법은 다양할 수 있음을 미리 알리고 작성합니다. 문제 정의 하나의 Epoch에 수많은 iteration이 있을 때, 제대로 훈련을 마치지 못하면 GPU Ram Over 현상이 발생합니다. 각 iteration은 독립적으로 동작하여 네트워크를 업데이트하기 위한 과정으로 각각의 GPU에서 저장된 Gradient 및 연산 값들은 GPU 어딘가에 저장되어 있다가 모델 마지...

#asymmetric

#pytorch

#pytorchdistribution

#Troubleshooting

#다중GPU

#딥러닝GPU

#딥러닝분산학습

#멀티지피유

#멀티지피유문제

#분산학습

#지피유정지

#파이토치분산학습

#MutliGPU싱크

#MultiGPU학습안됨

#barrer

#barrier

#DDP에러

#DDP오류방지

#Dist

#Distribution

#GPU

#GPUTrouble

#GPU다중학습

#multigpu

#MultiGPU에러

#학습정지

원문링크 : Multi-GPU 싱크 오류

![[2022 마이 블로그 리포트] 올해 활동 데이터로 알아보는 2022 나의 블로그 리듬](https://mblogthumb-phinf.pstatic.net/MjAyMjEyMTNfNiAg/MDAxNjcwOTE4NDcxODgz.fGo_Q_3y-2eAvlifarBxboxI2XSgaoIgj3I3ys5Wljog.1Nu1WKPGNI1fafdOThOUibYRMooXjt_4-zpNDAZrUjwg.PNG.jjunsss/my_blog_report.png?type=w2)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티