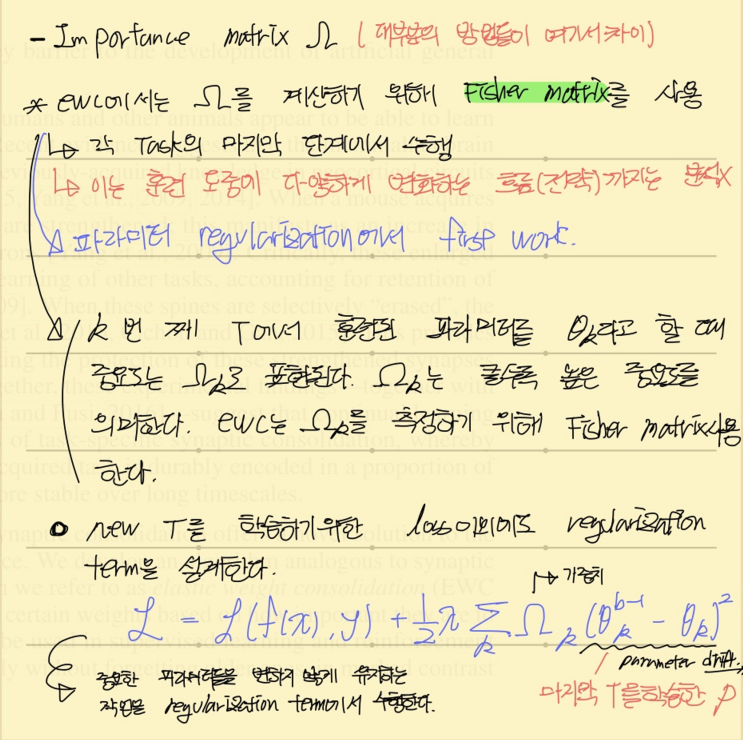

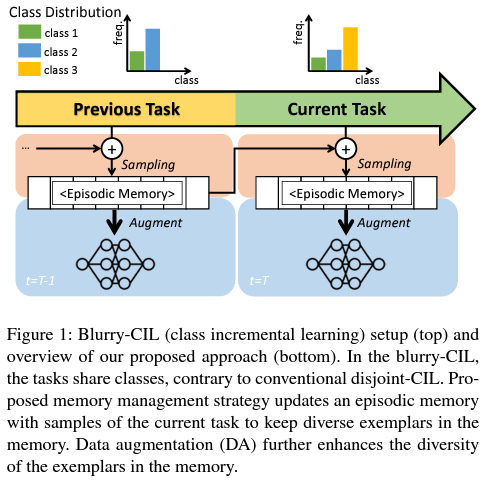

parameter regularization의 초기 방법론으로 제안된 EWC에 대해서 설명합니다. 간단한 매커니즘에 비해서 강력한 성능을 보였기에 아직도 비교대상군이 될 뿐더러 다양하게 변화시켜 많이 적용되는 방법입니다. 핵심 설명 당 정리는 Survey paper에서 정리한 내용입니다. 핵심적인 내용은 사실 파라미터의 중요한 Feature를 찾아낼 수 있는 Fisher matrix를 사용해서 이전의 정보가 변화하는 것을 규제하고 여분의 공간에 새로운 task에 대한 파라미터를 업데이트하는 것입니다. 위에서 가장 아래 부분에 작성된 파란색 부분이 해당 Loss를 말하는 것인데 필기가 좋지못해 죄송합니다. 아무튼 위에서 작성된 내용을 그림으로 살펴보면 아래와 같습니다. Task A에서 학습된 파라미터의 중심인 세타(A)^* 에서 중심 점(mean)을 찾고 해당 수치가 Task B에서 학습되는 공간으로 완전히 이동하는 것을 방지하는 것입니다. 위 그림에서는 아무런 규젤를 하지 않았을 때...

#ArtificialIntelligence

#가중치통합

#기억보존

#다중작업학습

#대량망각

#딥러닝

#모델정규화

#순차학습

#신경망

#인공지능

#작업학습

#지속학습

#지식통합

#평생학습

#WeightConsolidation

#TaskLearning

#CatastrophicForgetting

#ContinualLearning

#DeepLearning

#ElasticWeightConsolidation

#EWC

#FisherInformationMatrix

#KnowledgeConsolidation

#LifelongLearning

#MemoryPreservation

#ModelRegularization

#MultiTaskLearning

#NeuralNetworks

#SequentialLearning

#피셔정보행렬

원문링크 : Overcoming catastrophic forgetting in neural networks

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티