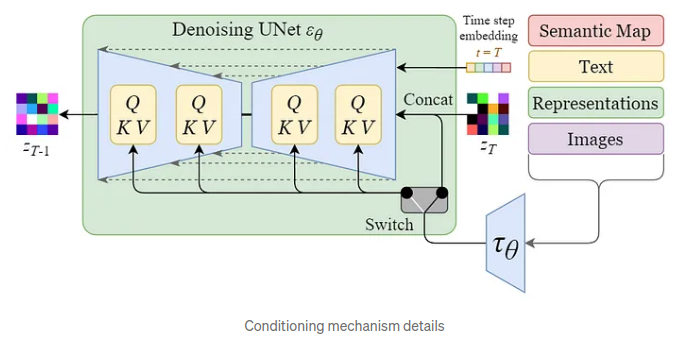

이번 글은 간단하게 최근 찾은 궁금증과 그에 관한 이유에 대해 정리합니다. 저는 최근 Deformable DETR(D-DETR)을 사용하다가 loss 부분을 건드리게 되었는데 코드를 보던 중 문득 이상한 것을 확인할 수 있었습니다. 아래와 같습니다. def forward(self, outputs, targets): """ This performs the loss computation. Parameters: outputs: dict of tensors, see the output specification of the model for the format targets: list of dicts, such that len(targets) == batch_size. The expected keys in each dict depends on the losses applied, see each loss' doc """ outputs_without_aux = {k: v for k, v in o...

#all_reduce

#loss정규화

#Meta

#num_boxes

#ObjectDetection

#분산학습

#분산학습Loss

#손실

#손실정규화

#Lossnormalizaiton

#LossNorm

#DDETR

#DDP

#DETR

#Distributed

#Fair

#instance

#Instsances

#Loss

#총인스턴스개수예시

원문링크 : DETR's Loss

![Avalanche [continual-learning] - 01](https://blogimgs.pstatic.net/nblog/mylog/post/og_default_image_160610.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티