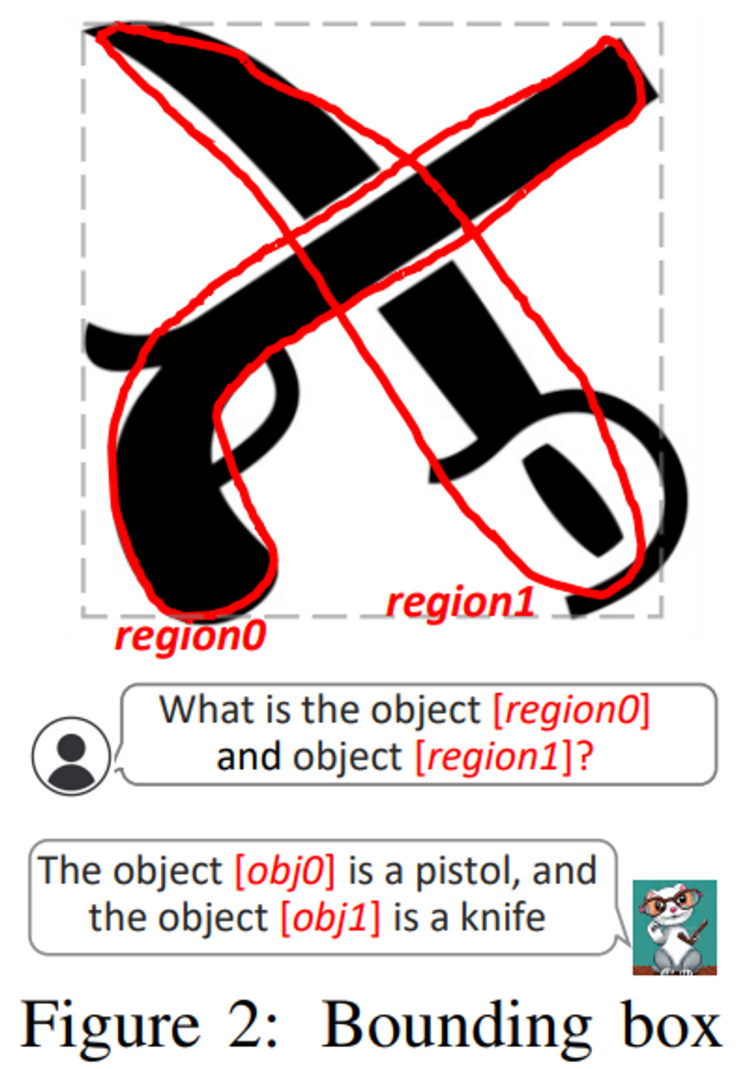

Introduction Vision-Language Model(VLM)이 발전함에 따라서 2가지가 중요시 여겨지는 추세라고 합니다. 이는 각각 refering과 grounding을 가르키게 되는데, refering은 특정 객체에 대한 정보를 입력단에서 주고 VLM(=mLLM)이 적절한 설명을 수행하도록 하는 작업을 합니다. 반면, grounding은 특정 이미지에 대한 설명을 주고, 그 설명에 알맞은 객체 혹은 포지션을 이미지 내에서 표시하는 작업을 의미합니다. 이 두 작업은 모두 이미지에 대한 세밀한 이해를 기반으로 하기 때문에 어려운 작업에 속하게 됩니다. 기존 연구들은 주로 referring와 grounding를 개별적으로 학습했으나, 사람들은 한 작업에서 얻은 지식을 다른 작업에 쉽게 일반화하고, 일상 대화와 추론에 referring/grounding 능력을 원활하게 통합할 수 있습니다. 이러한 관찰에서 영감을 받아 저자들은 다음 세 가지 주요 질문을 탐구합니다: Referr...

#Apple

#mLLM

#Multimodal

#MultimodelLLM

#QA

#QuestionAnswering

#REFERANDGROUNDANYTHINGANYWHEREATANYGRANULARITY

#reffering

#Vision

#VisionLanguage

#VisionLanguageModel

#Language

#InstrunctionFollowing

#description

#Ferret

#Foundation

#FreeFormInput

#GPT

#GPT4V

#GRIT

#Grounding

#imagecaptioning

#InstructionTuning

#VLM

원문링크 : FERRET: REFER AND GROUND ANYTHING ANYWHERE AT ANY GRANULARITY

![Avalanche [continual-learning] - 02](https://mblogthumb-phinf.pstatic.net/MjAyMzA0MDdfMTQx/MDAxNjgwODQ3NDQ4ODk2.CG95UJXoVx4l6VgN23_EY3lleDxRCPCeUwpdNd3TJBIg.ZPmoB4nHCUxA-CR25z2avoqzvtml8jZRWSdFdpUSUY8g.PNG.jjunsss/image.png?type=w2)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티