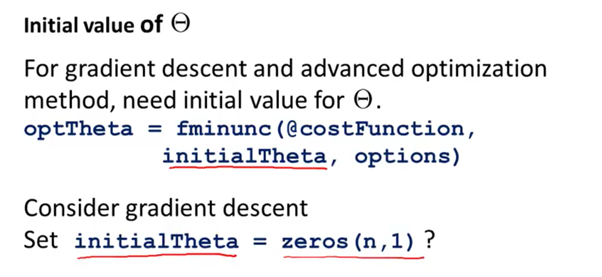

위 포스팅은 Standford University : Machine Learning – Andrew Ng의 강의를 바탕으로 쓰여졌습니다.. https://www.coursera.org/learn/machine-learning/ 안녕하세요. 이번 시간에는 Neural Network의 Backpropagation에서의 Random Initialization에 대해서 살펴보겠습니다. Gradient descent방법과 advanced optimization방법에서는 initial theta값이 필요하게 됩니다. InitialTheta값을 0인 n vector라고 정의해서 넣으면 어떻게 될까요? 모든 에 대하여 이면 간선의 weight가 같기 때문에 가 같게 되고, 가 되게 됩니다. 그렇기 때문에 theta값이 업데이트 되더라도 동일하게 업데이트가 되기 때문에 문제가 발생하게 됩니다. 그래..........

원문링크 : Lec36. Neural Network Backpropagation Random Initialization

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티