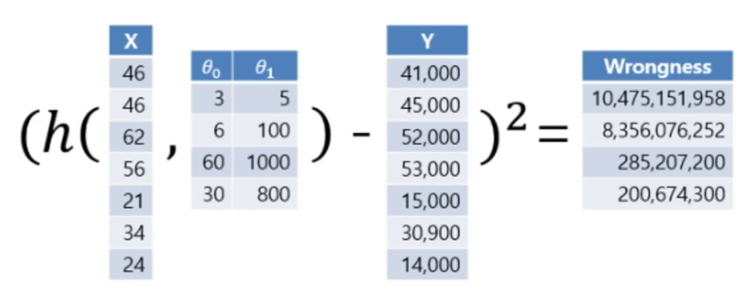

비용 함수 보통의 Cost Function의 정의는 J라는 함수를 많이 쓰입니다. J의 매개변수는 θ로 J(θ)로 쓰입니다. 전 글에서 보았듯이 1차함수에 θ0, θ1로 치환하여 본 것과 같이 θ는 벡터 형식으로 들어가게 됩니다. θ = [θ0 θ1] 즉, J(θ0, θ1)로 정의가 됩니다. 이를 식으로 나타내었을 때 아래와 같이 처리가 됩니다. 완벽히 이해는 못 하겠지만 h라는 함수에다가 학습 세트(x^(i))을 넣게 되면 임의의 가짜 y가 나오게 되고, 실제 y의 i 번째와 빼지게 되면 거의 동일하다면 0과 가까이 나오게 되고, 차이가 크다면 멀어지는 갭을 가지게 됩니다. 마지막의 제곱의 경우는, 음수일 경우를 대비해 양수로 만들어주기 위한 과정입니다. 이 과정을 사진으로 보게 되면 아래와 같이 동작하게 됩니다. 전 글에서 보았듯이 그래프가 가까워진 것처럼 Wrongness가 줄어든 것을 볼 수 있습니다. 이러한 방식으로 Wrongness를 minimize 시키는 방향으로 진행을...

원문링크 : 딥러닝의 원리 - 2. 비용 함수

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티