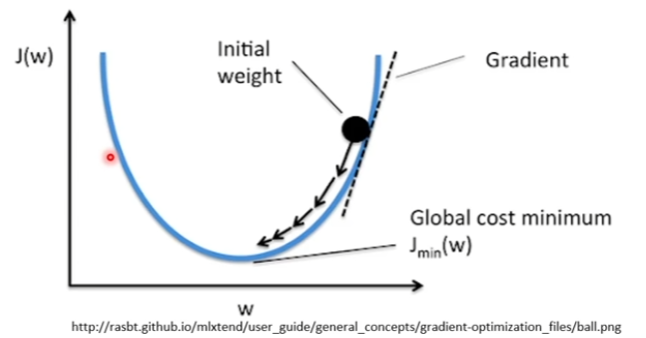

전 글에서 Cost Function을 이용해 결과 값을 도출하는 방식은 비효율적인 방법이라고 설명했습니다. 그러면 보완하기 위한 경사하강법에 대해 알아보도록 하겠습니다. 경사하강법 J함수가 가지고 있는 매개변수 θ는 w(weight)라고 표기할 수 있는데 J함수를 미분을 계속하여 가장 밑까지 도달하였을 때 멈추는 방식을 사용하는 것이 경사하강법입니다. J함수가 주어졌을 때 J함수를 미분하는 공식은 아래와 같이 구성할 수 있습니다. J(θ)를 편미분 한다음 a 만큼 옮기고 원래 J(θ) 만큼 옮긴다면 a 만큼 움직이면서 점점 아래로 이동하게 됩니다. 즉, 학습을 시킬 때마다 점점 결과에 가까워지는 것을 볼 수 있게 됩니다. 좀 더 가시적으로 표현하자면 위와 같이 표현할 수 있습니다. GDM(Gradient descent Method) - 경사하강법 MCM(Monte Carlo method) - 때려 맞추기(랜덤으로 학습) 파란 쪽으로 갈수록 Loss가 낮아지고, 빨간색으로 갈수록 Lo...

원문링크 : 딥러닝의 원리 - 3. 경사하강법

![[Python] Flask를 이용한 Rest API 서버 구축 - 1](https://mblogthumb-phinf.pstatic.net/MjAyMzAzMTdfNzIg/MDAxNjc5MDQyNDAyMTA1.81jv1AOwhWrrwMjekZODUK9QEeqeJ2uZxj-d4BCIo44g.uyB1USVLhRaTILUCfs_n3dk9eNw__-q1wN4M4wwHXSkg.PNG.zlatmgpdjtiq/image.png?type=w2)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티