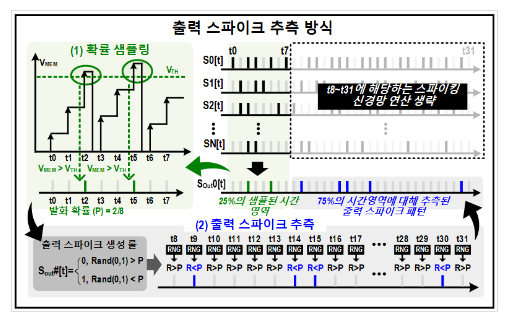

뉴로모픽 컴퓨팅 기반의 초저전력 거대 언어모델 AI반도체 상보형-트랜스포머 개발 2024.03.06 과학기술정보통신부 KAIST, 뉴로모픽 컴퓨팅 기반의 초저전력 거대 언어 모델 인공지능반도체 핵심기술 ‘상보형-트랜스포머’ 개발 - 삼성 28나노공정 활용, GPT-2 거대 언어 모델을 400mW전력 소모로 성공적 구동 - GPU(엔비디아 A100) 대비 소모전력은 625배, 칩 면적 41배 작은 인공지능 반도체 핵심기술 개발 - 온디바이스AI의 핵심인 초저전력·고성능 인공지능반도체를 뉴로모픽 컴퓨팅으로 구현 과학기술정보통신부(장관 이종호, 이하 ‘과기정통부’)는 KAIST(총장 이광형) PIM반도체 연구센터와 인공지능반도체 대학원 유회준 교수 연구팀이 400밀리와트 초저전력을 소모하면서 0.4초 초고속으로 거대 언어 모델을 처리할 수 있는 인공지능 반도체인 ‘상보형-트랜스포머* (Complementary-Transformer)’를 삼성 28나노 공정을 통해 세계 최초로 개발했다고 밝...

원문링크 : 뉴로모픽 컴퓨팅 기반의 초저전력 거대 언어모델 AI반도체 상보형-트랜스포머 개발

![[경기] 2022년 1차 스마트공장 구축지원 스마트공장 전담인력 교육 안내](https://mblogthumb-phinf.pstatic.net/MjAyMjEwMjdfMjE5/MDAxNjY2ODcxMzczMzU5.1hBSLsq0f0Fg8LwmQKflsyTe0-4MGyjTpjustu0gm_Mg.HBxmyiP_6q4lL_2f_9BHSu4iHercKVlv-4ORIm025uUg.PNG.ash1106/image.png?type=w2)

![[KOTRA 해외시장뉴스] 미국의 환율-무역 연계 수입규제 동향과 전망](https://blogimgs.pstatic.net/nblog/mylog/post/og_default_image_160610.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티