![[Short Paper Review] ResiDual: Transformer with Dual Residual Connections [Short Paper Review] ResiDual: Transformer with Dual Residual Connections](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FuUjgE%2Fbtsfg32i82A%2Few6keV1ZxfWAEDiCzSdw41%2Fimg.png)

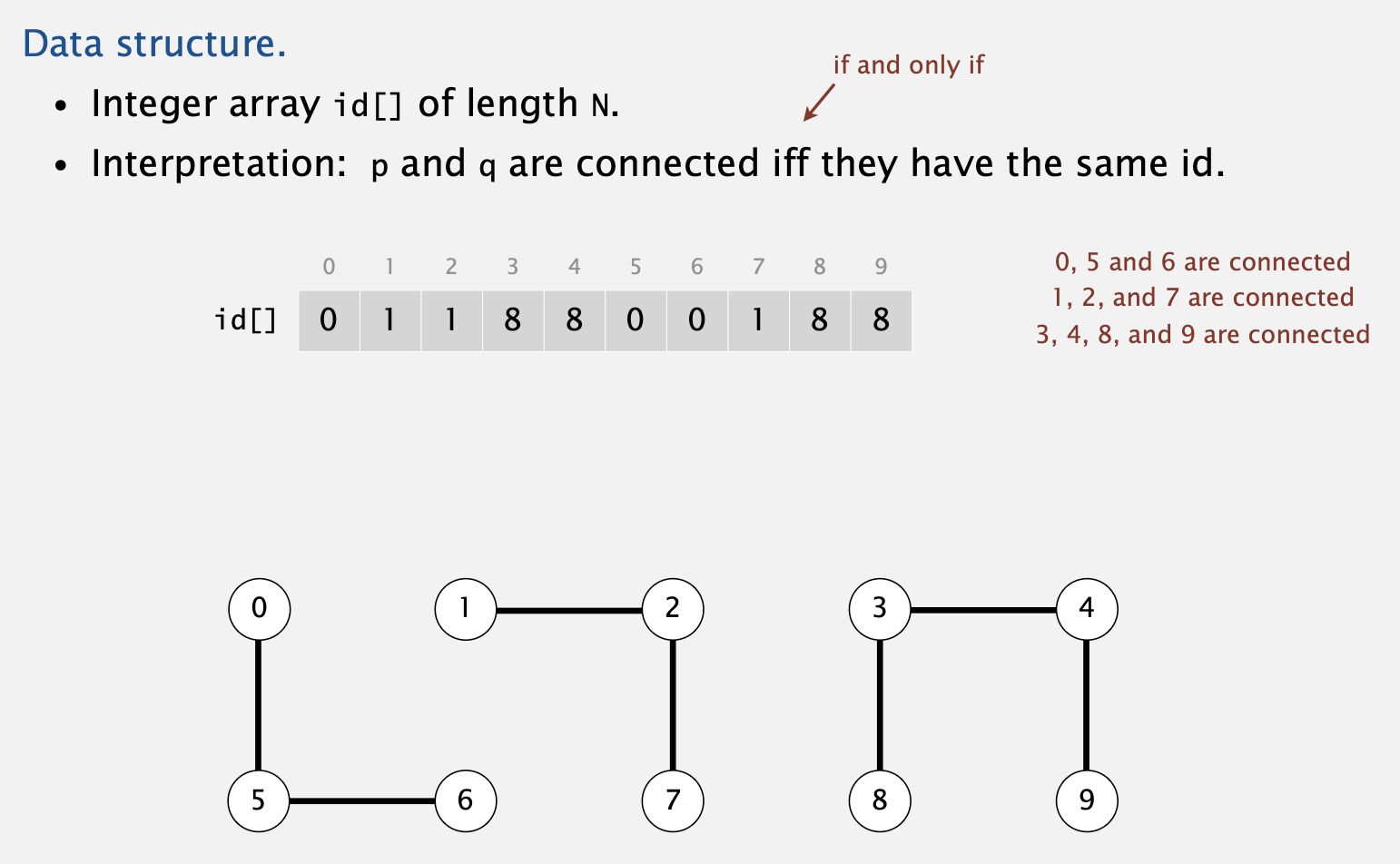

usechatgpt init success 최근에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ Layer Normalization을 residual block의 앞과 뒤, 동시에 적용함으로써 pre/post 두 방식의 장점은 살리고 단점은 극복한 모델 배경 기존 NLP 모델들이 극복하지 못했던 long sequence에 대한 한계를 transformer의 아키텍쳐가 극복해냄으로써 NLP 분야는 눈부시게 발전했습니다. 문장이 길어지면서 전체적인 맥락을 고려하지 못하게 되는 상황이 아주 흔했는데, 이런 문제를 해결하기 위해서 sequence 앞 부분의 정보를 뒤쪽으로 전달하며 업데이트하는 방식이 등장했습니다. BERT 계열의 모델들은 transf..

원문링크 : [Short Paper Review] ResiDual: Transformer with Dual Residual Connections

![[BOJ] 14500 : 테트로미노 [브루트포스](Python) [BOJ] 14500 : 테트로미노 [브루트포스](Python)](http://t1.daumcdn.net/tistory_admin/static/images/openGraph/opengraph.png)

![<Prompt, Agent> [SPP] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration (2023.07) <Prompt, Agent> [SPP] Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration (2023.07)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FblQdle%2FbtsAzcjIHyA%2F8pX7LIXIKAbrAaGDOXIHI1%2Fimg.png)

![[Paper Review] BERT - Pre-training of Deep Bidirectional Transformers for Language Understanding [Paper Review] BERT - Pre-training of Deep Bidirectional Transformers for Language Understanding](http://blog.kakaocdn.net/dn/0ykNs/btr6NlxWGoa/UPaOFJJAwjRfsLwLd1Ckq1/img.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티