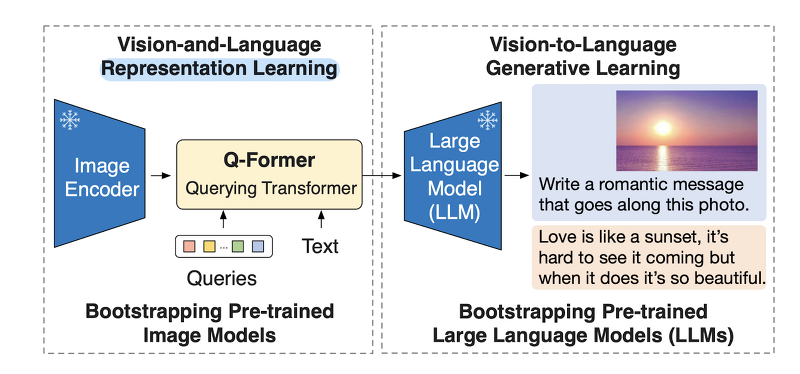

최근(2023.06)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success BLIP-2, generic & efficient 사전 학습 Vision & Language Model. frozen image encoder & frozen LLM으로 Querying Transformer를 2-step으로 학습. 배경 이전의 vision-language model을 특정 태스크에 맞게끔 end-to-end 학습하는 방식은 지나치게 많은 자원을 필요로 한다는 문제점이 있었습니다. 본 논문은 자원상의 한계를 극복하면서도 준수한 vision-language model을 만들기 위한 사전 학습 전략을 제시하고 있습니다. ..

![[Kaggle] OSError, Connection error? 인터넷을 연결하는 방법..(+ GPU 설정) [Kaggle] OSError, Connection error? 인터넷을 연결하는 방법..(+ GPU 설정)](http://blog.kakaocdn.net/dn/v3KLe/btr0KQWCjCc/H0oZGD9saPlCPgA2i8nOlk/img.png)

![[대학원생 필수!] 논문 관리 프로그램 Zotero 추천 (WebDAV 연결, iPad annotation 싱크 관리) [대학원생 필수!] 논문 관리 프로그램 Zotero 추천 (WebDAV 연결, iPad annotation 싱크 관리)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FPMH6r%2FbtsFDFQmkcw%2FTkxkN9LcADufK8RWH2pBI0%2Fimg.png)

![<Retrieval> [RAG] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks (2021.04) <Retrieval> [RAG] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks (2021.04)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbS4ww9%2FbtsAbosxR5p%2FkXifNSEhkT4VVSwztMzTlk%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티