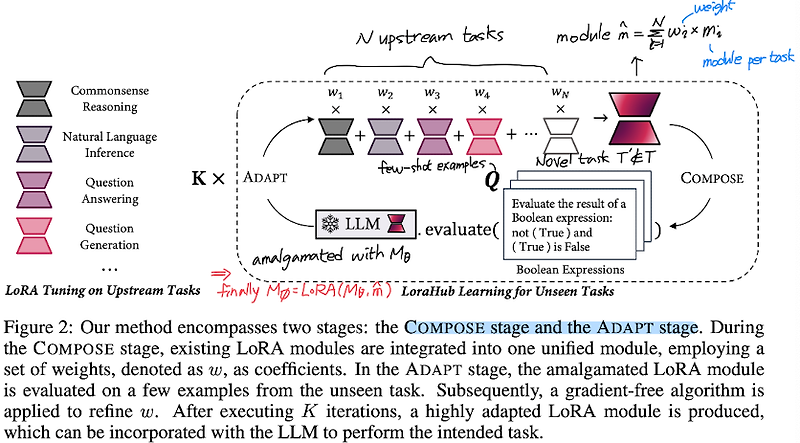

최근(2023.07)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ 여러 개의 LoRA 모듈을 구성하여 task 간 일반화 성능이 뛰어난 LoRA 허브를 제시. few-shot 상황에서 in-context learning 능력이 준수함을 BBH(Big-Bench Hard) 벤치마크로 검증 배경 모델의 학습 가능한 파라미터수가 날이 갈수록 늘어나자 이를 최소화하며 동일한 성능을 유지하고자 하는 연구들이 이어지고 있습니다. 그중에서도 행렬 분해를 통해 학습 가능한 파라미터의 수를 획기적으로 줄이면서 기존의 성능에 버금가는 모델이 될 수 있도록 하는 학습 방식으로, LoRA가 가장 크게 주목을 받았죠. 하지만 이는 LLM이 가진 일반화 능력을 포기..

원문링크 : <PEFT> LoraHub: Efficient Cross-Task Generalization via Dynamic LoRA Composition

![[SSAFY 8기] 싸피 8기 불합격 후기(비전공자) [SSAFY 8기] 싸피 8기 불합격 후기(비전공자)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FdnXgEz%2FbtrNwGtCDq4%2FP6QeKRya9Elk6Wh41dKgTK%2Fimg.png)

![<Benchmark> [MMHAL-BENCH] Aligning Large Multimodal Models with Factually Augmented RLHF <Benchmark> [MMHAL-BENCH] Aligning Large Multimodal Models with Factually Augmented RLHF](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fb0UEt1%2FbtswcJfMXD9%2FRuZBOEa4TDK0YGSMhCS0Y1%2Fimg.png)

![[Short Paper Review] Training Verifiers to Solve Math Word Problems [Short Paper Review] Training Verifiers to Solve Math Word Problems](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbyDbRo%2FbtshAzlhTvI%2FcePG5kmJDRU7do82AS9GIK%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티