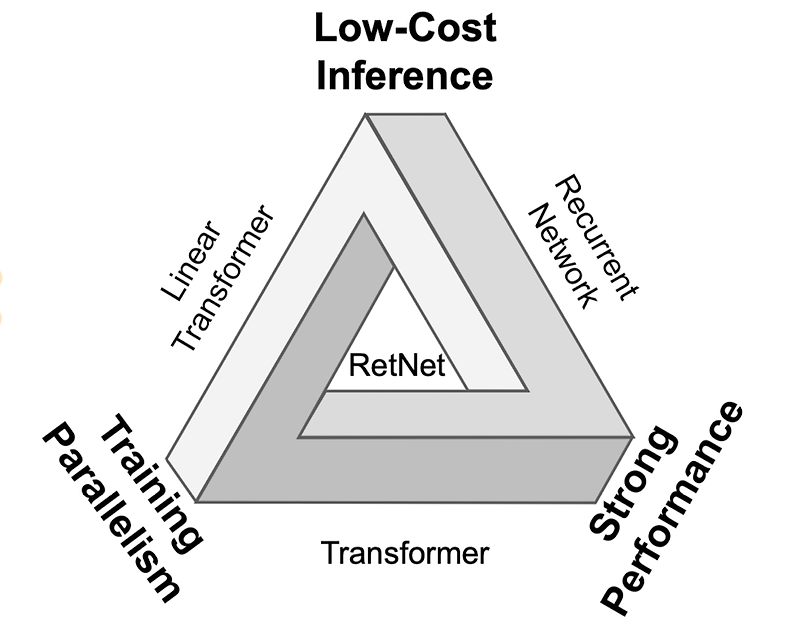

최근(2023.07)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success LLM의 기반이 되는 Retentive Network (RETNET)을 제안. scaling results, parallel training, low-cost deployment, efficient inference를 달성했다고 주장. 배경 트랜스포머 기반의 모델들은 그 뛰어난 성능 덕분에 많은 분야를 집어 삼키고 있지만, 지나치게 많이 요구되는 메모리 사용량과 연산량으로 인해 사용에 제약이 많습니다. 따라서 빠른 속도로 연산이 가능하면서도 준수한 성능을 낼 수 있는 모델에 대한 연구는 다방면으로 이뤄지고 있습니다. 모델의 성능과 관..

원문링크 : <Attention> Retentive Network: A Successor to Transformer for Large Language Models

![<Multi-modal> [BEiT] Image as a Foreign Language: BEiT Pretraining for All Vision and Vision-Language Tasks <Multi-modal> [BEiT] Image as a Foreign Language: BEiT Pretraining for All Vision and Vision-Language Tasks](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FEM2gM%2FbtsrBNmsaYw%2FC1pkVRPirkLZ1A4O1ZQFsk%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티