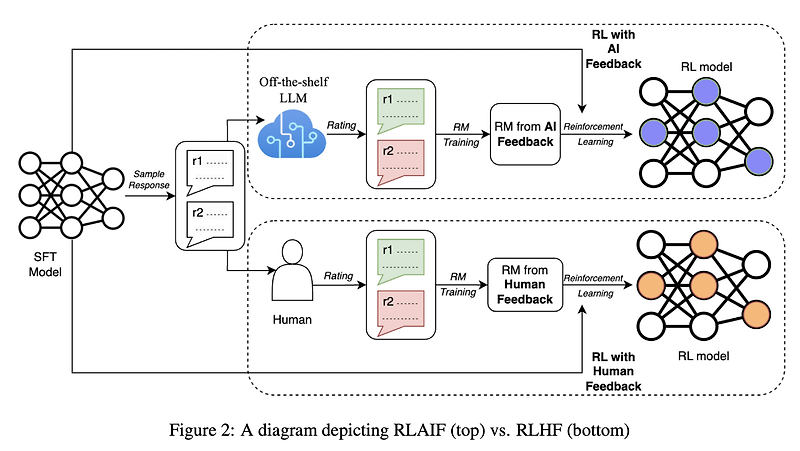

최근(2023.09)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [Google Research] LLM을 요약 태스크에 대해 학습시킬 때 반영하는 '사람'의 선호 대신 'AI'의 선호를 반영하는 RLAIF 배경 ChatGPT와 같은 LLM들이 주목을 받게 된 데 가장 큰 기여를 한 것은 RLHF(Reinforcement Learning with Human Feedback)이라고 해도 과언이 아닐 것입니다. reward 모델이 사람의 선호를 학습하고, 이를 바탕으로 언어 모델을 추가 학습하는 방식입니다. 그런데 이러한 방식 역시 사람의 선호를 나타낼 수 있는 pair 데이터셋이 필요하기 때문에, L..

원문링크 : <Alignment> RLAIF: Scaling Reinforcement Learning from Human Feedback with AI Feedback

![<RAG, Refinement> [CRAG] Corrective Retrieval Augmented Generation (2024.01) <RAG, Refinement> [CRAG] Corrective Retrieval Augmented Generation (2024.01)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FzkJyi%2FbtsEvVFkbXv%2FN1XhGKqaSeEqmKAnA813qk%2Fimg.png)

![<Retrieval> [RAG] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks (2021.04) <Retrieval> [RAG] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks (2021.04)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbS4ww9%2FbtsAbosxR5p%2FkXifNSEhkT4VVSwztMzTlk%2Fimg.png)

![[프로그래머스] 추억 점수 (Python) [프로그래머스] 추억 점수 (Python)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Ft1.daumcdn.net%2Ftistory_admin%2Fstatic%2Fimages%2FopenGraph%2Fopengraph.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티