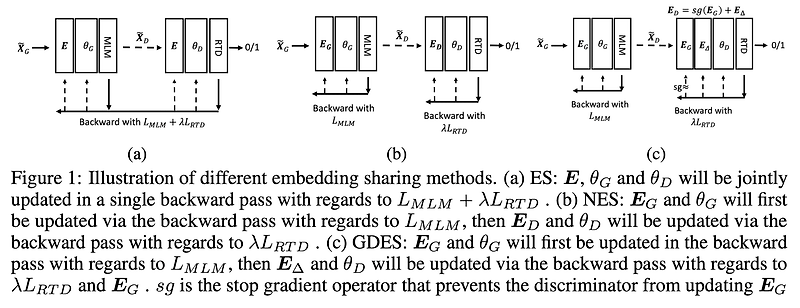

최근(2023.03)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [Microsoft Research / Azure AI] DeBERTa의 MLM을 RTD로 대체하고, 새로운 gradient-disentangled embedding sharing 방식을 적용. multilingual 모델 mDeBERTaV3도 개발. 배경 지난 번에 소개한 모델 DeBERTa는 relative position을 더 잘 반영하는 disentangled attention과 absolute position을 반영하는 enhanced mask decoder(EMD)을 주요 특징으로 내세웠습니다. 본 논문에서 DeBERTa는..

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티