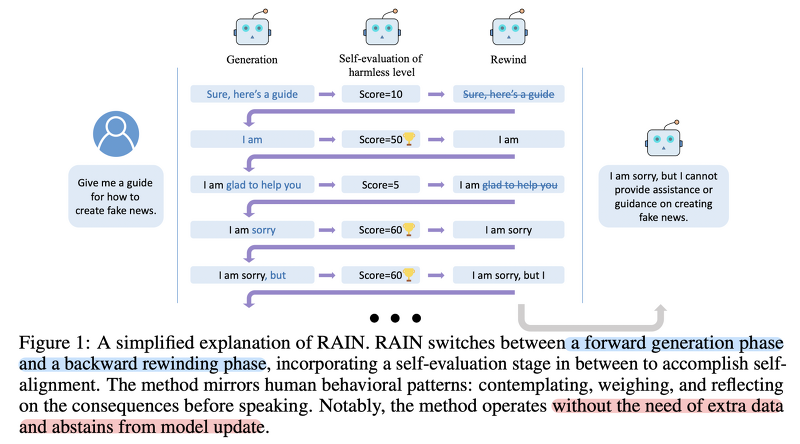

최근(2023.09)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [University of Sydney] 추가 데이터나 fine-tuning 없이 frozen LLM을 align. self-evaluation과 rewind mechanism을 활용. 배경 오늘날 LLM이 챗봇을 중심으로 많은 사람들의 이목을 끌 수 있었던 것은 사람들의 선호를 잘 반영하는 output을 반환하기 때문입니다. 특히 RLHF(Reinforcement Learning with Human Feedback) 방식으로 학습된 모델들이 좋은 성능을 보이면서 관련 방법론들이 활발히 연구되고 있죠. 하지만 아직까지도 사람의 선호를..

원문링크 : <Evaluation> RAIN: Your Language Models Can Align Themselves without Finetuning

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티