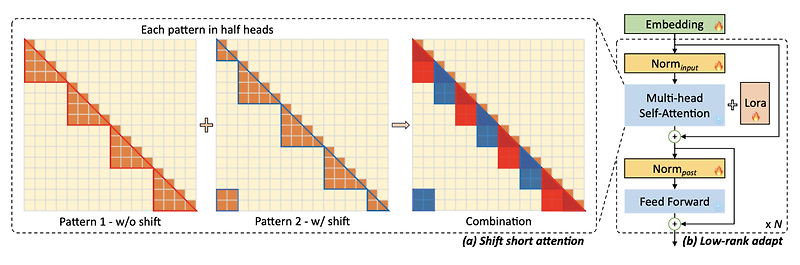

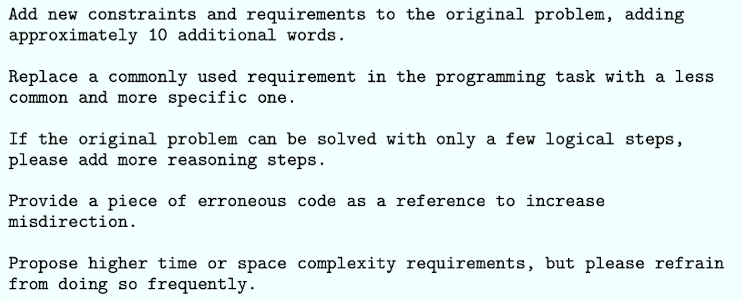

최근(2023.09)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [MIT] 사전학습된 LLM의 context size를 확장하는 efficient fine-tuning 기법, LongLoRA. sparse local attention 방식 중 하나로 shift shoft attention(S^2-Attn)를 제안하고, trainable embedding & normalization을 통해 computational cost를 대폭 줄이면서도 기존 모델에 준하는 성능을 보임. Fine-tugning을 위한 3K 이상의 long context question-answer pair dataset, Lon..

원문링크 : <Attention> LongLoRA: Efficient Fine-tuning of Long-Context Large Language Models

![<LK Lab, Retrieval> [ToC] Tree of Clarifications: Answering Ambiguous Questions with Retrieval-Augmented Large Language Models (2023.10) <LK Lab, Retrieval> [ToC] Tree of Clarifications: Answering Ambiguous Questions with Retrieval-Augmented Large Language Models (2023.10)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbU7Swm%2FbtsAfCwOXdI%2FqMFbJ23XYDpiph4ufkwyRk%2Fimg.png)

![[Kaggle/GoogleDrive] 캐글에서 구글 드라이브에 저장된 데이터 불러오기 가이 [Kaggle/GoogleDrive] 캐글에서 구글 드라이브에 저장된 데이터 불러오기 가이](http://blog.kakaocdn.net/dn/dlSKwZ/btr4wFdQ8kV/QGNgHnqcKQyNYruvMYWCSk/img.png)

![[Short Paper Review] Training Verifiers to Solve Math Word Problems [Short Paper Review] Training Verifiers to Solve Math Word Problems](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbyDbRo%2FbtshAzlhTvI%2FcePG5kmJDRU7do82AS9GIK%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티