![<Attention> [Attention Sinks] Efficient Streaming Language Models with Attention Sinks <Attention> [Attention Sinks] Efficient Streaming Language Models with Attention Sinks](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FOwild%2FbtsxgnCJD5h%2FiVEfgr45qj4snHrI9N4zQ0%2Fimg.png)

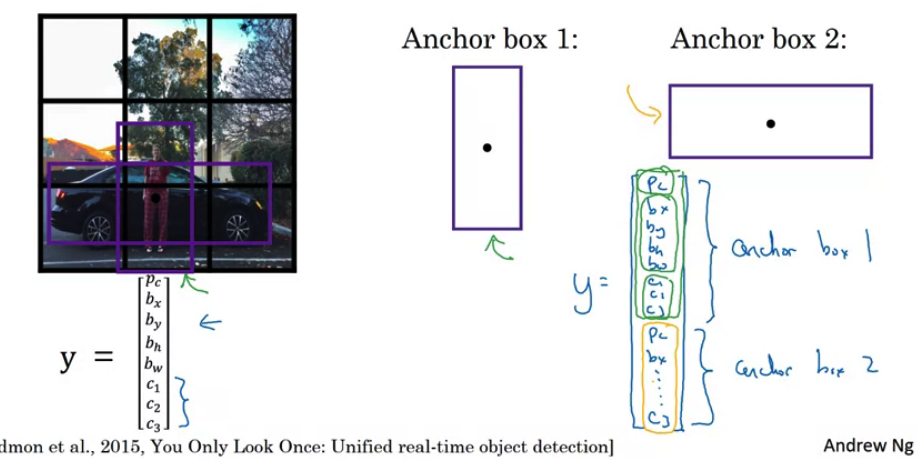

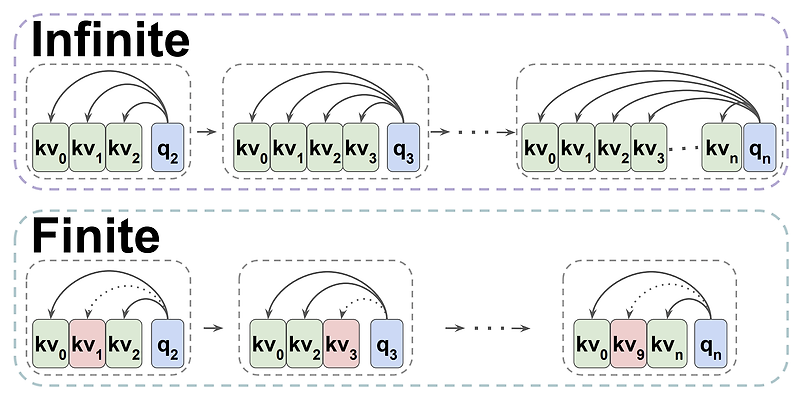

최근(2023.09)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [MIT, Meta AI] initial token의 Key, Value를 attention 과정에서 keep하는 방식, Attention Sinks 유한한 길이의 attention window로 학습된 LLM이 무한한 길이의 sequence에 대해 일반화 할 수 있도록 하는 StreaingLLM. 배경 LLM이 여러 태스크에서 뛰어난 퍼포먼스를 보여주는 것은 맞지만, 입력이 특정 길이를 넘어서게 되면 이를 전혀 처리하지 못한다는 문제점을 갖고 있죠. 그런다고 입력 길이를 늘려주자니 attention 연산이 quadratic 하다 보..

원문링크 : <Attention> [Attention Sinks] Efficient Streaming Language Models with Attention Sinks

![<LLM> [Analogical Prompting] Large Language Models as Analogical Reasoners <LLM> [Analogical Prompting] Large Language Models as Analogical Reasoners](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FMpTFm%2FbtsxicWy0as%2FUzQQC6VbiTYT2kkYKRZhck%2Fimg.png)

![<Retrieval> [Short Paper Review] Retrieval meets Long Context Large Language Models <Retrieval> [Short Paper Review] Retrieval meets Long Context Large Language Models](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FEu8do%2FbtsyaUM0NMO%2F5Bo4cSQAn6hpktZKgExHdK%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티