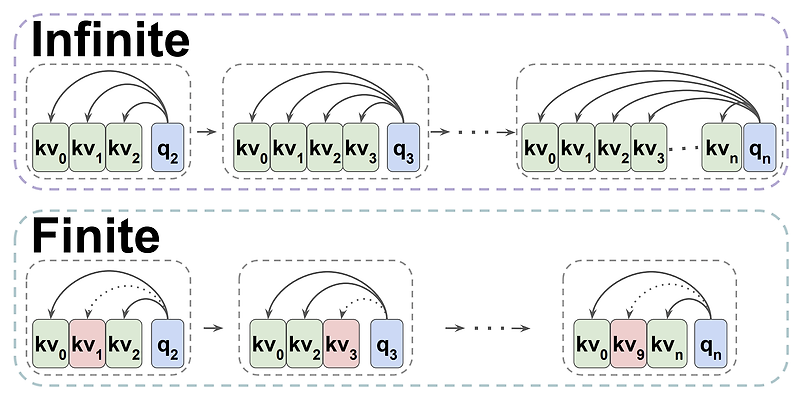

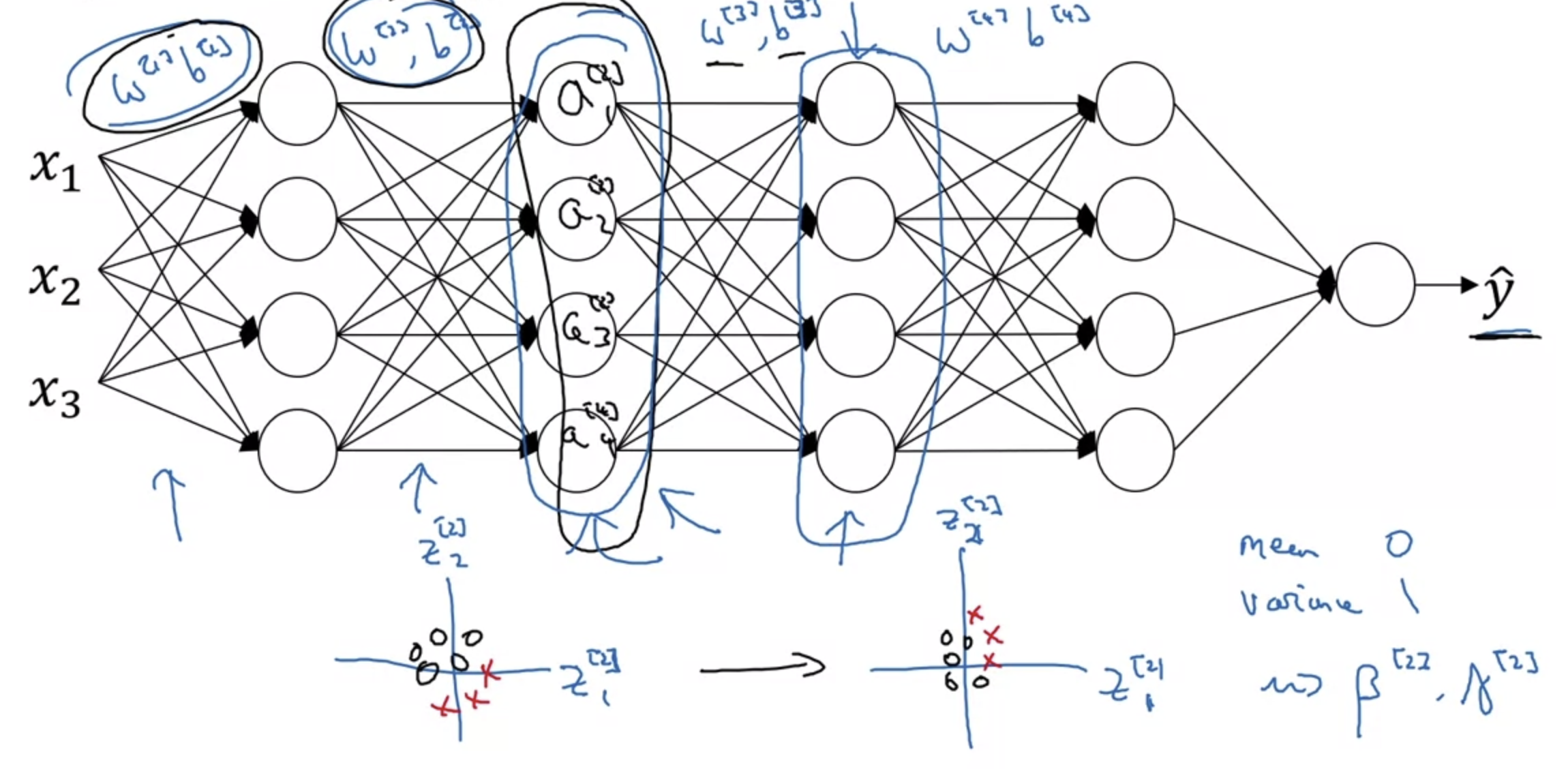

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [FAIR, AI at Meta, The Hebrew University of Jerusalem] - decoder-only transformer가 infinite multi-state RNNs으로 개념화 될 수 있다는 것을 입증 - 나아가 사전학습된 transformers를 finite multi-state RNNs으로 전환 - 이때 사용되는 새로운 compression policy, TOVA를 제시 1. Introduction transformer의 아키텍쳐가 자연어처리 분야에서 핵심으로 자리잡게 되었지만, 이것과 기존 RNN과의 관계에 대한..

원문링크 : <LLM, RNN> Transformers are Multi-State RNNs (2024.01)

![[Short Paper Review] We're Afraid Language Models Aren't Modeling Ambiguity [Short Paper Review] We're Afraid Language Models Aren't Modeling Ambiguity](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FclTmUl%2FbtsfdW3X6Dj%2FBwU3WYMZruoxTUcWdFq391%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티