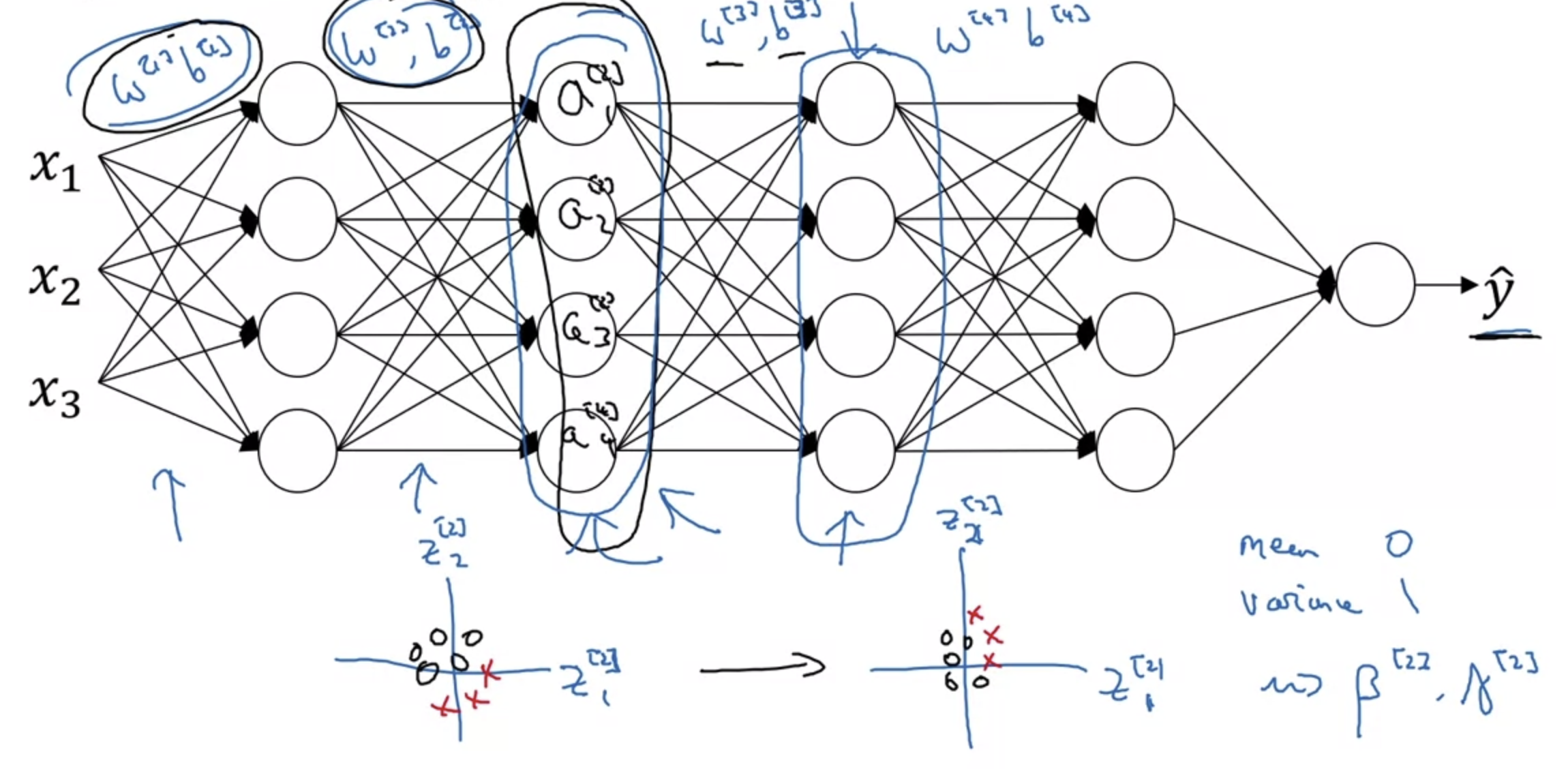

1. Normalizing Activation in a Network Normalizing inputs to speed up learning gradient descent 과정에서 빠르게 local minima에 도달하는데 normalization이 도움이 된다는 것은 이전에 배웠다. 그렇다면 neural network에서, 즉 hidden layer가 여러 개인 경우에는 normalization을 언제언제 적용해야 할까? 다시 말하자면 input만 normalization을 해야할까? 아니면 activation function을 통해 나온 결과값에도 적용을 해야할까? 교수님은 둘 다 하는 것을 default로 생각하라고 하셨다. activation function의 결과가 어떻게 나올지는 확실히 예측할..

원문링크 : Batch Normalization

![[프로그래머스] 요격 시스템 (Python) [프로그래머스] 요격 시스템 (Python)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Ft1.daumcdn.net%2Ftistory_admin%2Fstatic%2Fimages%2FopenGraph%2Fopengraph.png)

![[Short Paper Review] ResiDual: Transformer with Dual Residual Connections [Short Paper Review] ResiDual: Transformer with Dual Residual Connections](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FuUjgE%2Fbtsfg32i82A%2Few6keV1ZxfWAEDiCzSdw41%2Fimg.png)

![<Retrieval> [RAG] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks (2021.04) <Retrieval> [RAG] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks (2021.04)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbS4ww9%2FbtsAbosxR5p%2FkXifNSEhkT4VVSwztMzTlk%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티