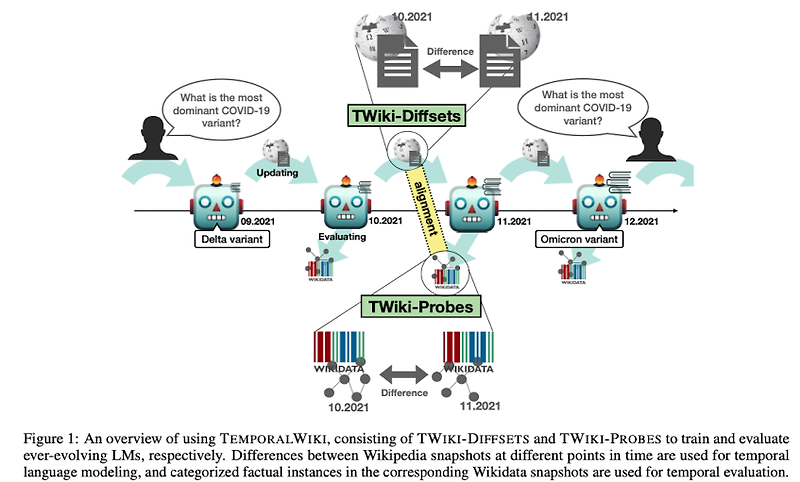

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ [KAIST, LG AI Research, Korea University] - LM이 이전의 지식을 그대로 보유하고 있는지, 그리고 최신의 지식을 습득했는지 확인할 수 있는 벤치마크 - TWiki-Diffsets, TWiki-Probes 두 개의 셋으로 구성 - diff data에 대해 LM을 continual learning 하는 것이 perplexity 관점에서 준수하다는 결과 배경 LM의 능력을 평가하는 데이터셋은 대부분 static train / test 데이터셋의 misalignment는 closed-boo..

![[Short Paper Reveiw] AutoML-GPT: Automatic Machine Learning with GPT [Short Paper Reveiw] AutoML-GPT: Automatic Machine Learning with GPT](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FlTOBN%2FbtsgELT21pR%2FgY6SyNlE9r1atRKNMX1j70%2Fimg.png)

![[BOJ] 1780 : 종이의 개수 [분할](Python) [BOJ] 1780 : 종이의 개수 [분할](Python)](http://t1.daumcdn.net/tistory_admin/static/images/openGraph/opengraph.png)

![<LLM> [Google DeepMind] Gemma: Open Models Based on GeminiResearch and Technology (2024.02) <LLM> [Google DeepMind] Gemma: Open Models Based on GeminiResearch and Technology (2024.02)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FcReVIh%2FbtsFcRCOI26%2FkDhTuY07RGtIe8DbMSSEMK%2Fimg.png)

![<Benchmark, CoT> [Google, REVEAL] A Chain-of-Thought Is as Strong as Its Weakest Link: A Benchmark for Verifiers of Reasoning Chains (2024.02) <Benchmark, CoT> [Google, REVEAL] A Chain-of-Thought Is as Strong as Its Weakest Link: A Benchmark for Verifiers of Reasoning Chains (2024.02)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fbny1Sd%2FbtsEmEY0n8e%2FkCSFELsBcqGUQwxc19luh0%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티