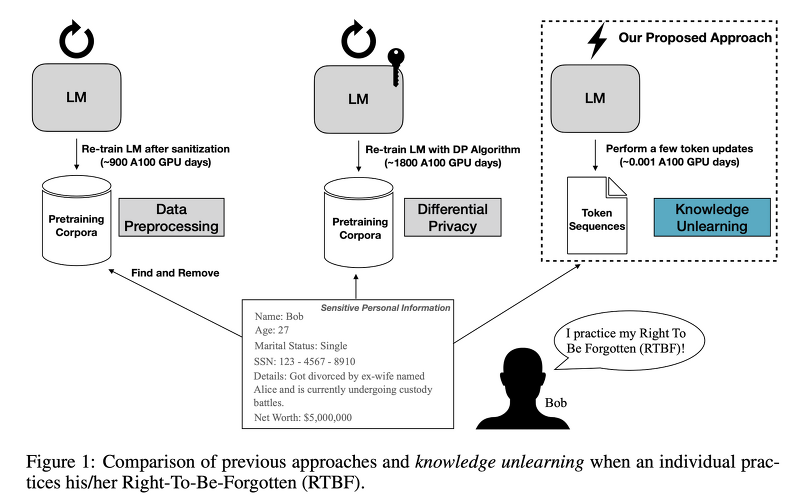

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ [KAIST, LG AI Research, Knokuk University, Seoul National University, University of Illinois Chicago] - LM이 지난 privacy risk를 줄여주기 위한 대안으로 knowledge unlearning을 제안 - target sequence에 대해 gradient ascent를 적용하는 것만으로도 모델의 성능 하락 없이 forgetting을 쉽게 달성할 수 있음 - sequential unlearning이 모든 데이터를 한꺼번에 처리하는 것보다 더 바람직한 결과로 이어짐 배경 사전 학습된 언어 모델이 이름,..

원문링크 : <LK Lab, Evaluation> Knowledge Unlearning for Mitigating Privacy Risks in Language Models (2022.12)

![[BOJ] 6064 : 카잉 달력 [정수론](Python) [BOJ] 6064 : 카잉 달력 [정수론](Python)](http://t1.daumcdn.net/tistory_admin/static/images/openGraph/opengraph.png)

![<LLM> [Qwen] Qwen Technical Report <LLM> [Qwen] Qwen Technical Report](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbA6rTE%2Fbtsv5ocNUbg%2FvrGCfyG6jpkPKwliiZ90Mk%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티