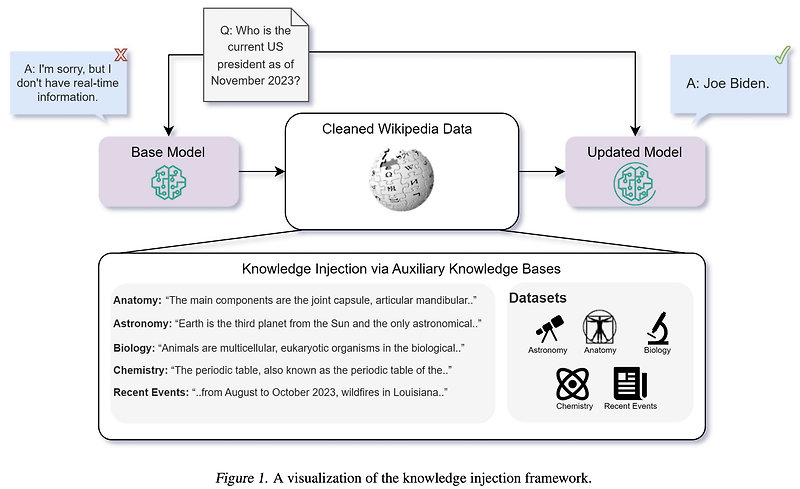

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [Microsoft, Israel] - LLM이 사전학습 동안 보지 못했던 정보를 추가 습득하도록 하는 방식 중 fine-tuning과 retrieval-augmented generation (RAG)를 비교 - 두 방식 중에서 RAG가 훨씬 성능이 좋은 것으로 확인됨. 심지어 base with RAG > fine-tuned with RAG 1. Introduction LLM은 다양한 도메인의 지식을 보유하고 있음이 잘 알려져 있으나 여전히 명확한 한계가 존재함 static하다, 즉 새로운 정보가 업데이트 되지 않는다 특수한 도메인의 전문 지식은..

![<Prompting> [OPRO] Large Language Models as Optimizers <Prompting> [OPRO] Large Language Models as Optimizers](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FKWeUH%2FbtsuGlGXaDX%2FLDrKWe4zONRWc4AI4eqamK%2Fimg.png)

![<Retrieval> [DSI] Transformer Memory as a Differentiable Search Index (2022.02) <Retrieval> [DSI] Transformer Memory as a Differentiable Search Index (2022.02)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbwxZjL%2FbtsAs7vzXIv%2FcZzO6B9p9MmLeQSeuhjwuk%2Fimg.png)

![<LK Lab, Multi-modal> [ZeroTA] Zeor-Shot Dense Video Captioning by Jointly Optimizing Text and Moment (2023.01) <LK Lab, Multi-modal> [ZeroTA] Zeor-Shot Dense Video Captioning by Jointly Optimizing Text and Moment (2023.01)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fpeip9%2FbtsAbm9nmuY%2FI9Aiu9h7aUY0kmi8jU7jn0%2Fimg.png)

![[비전공자 취업 회고록] 영어영문학 전공자가 데이터 사이언티스트가 되기까지는 1년이 걸렸다(feat. 비전공자인데 개발자 해도 될까요?) [비전공자 취업 회고록] 영어영문학 전공자가 데이터 사이언티스트가 되기까지는 1년이 걸렸다(feat. 비전공자인데 개발자 해도 될까요?)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbYJXpE%2FbtshBl0SLzE%2FOKKUQIAP2iAM8JbPvFFZPK%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티