![<Supervision> [OpenAI] Weak-to-Strong Generalization: Eliciting Strong Capabilities With Weak Supervision (2023.12) <Supervision> [OpenAI] Weak-to-Strong Generalization: Eliciting Strong Capabilities With Weak Supervision (2023.12)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FchVeMM%2FbtsDZjswT8s%2FXVRn6YBv2DVMT6nsGiny2K%2Fimg.png)

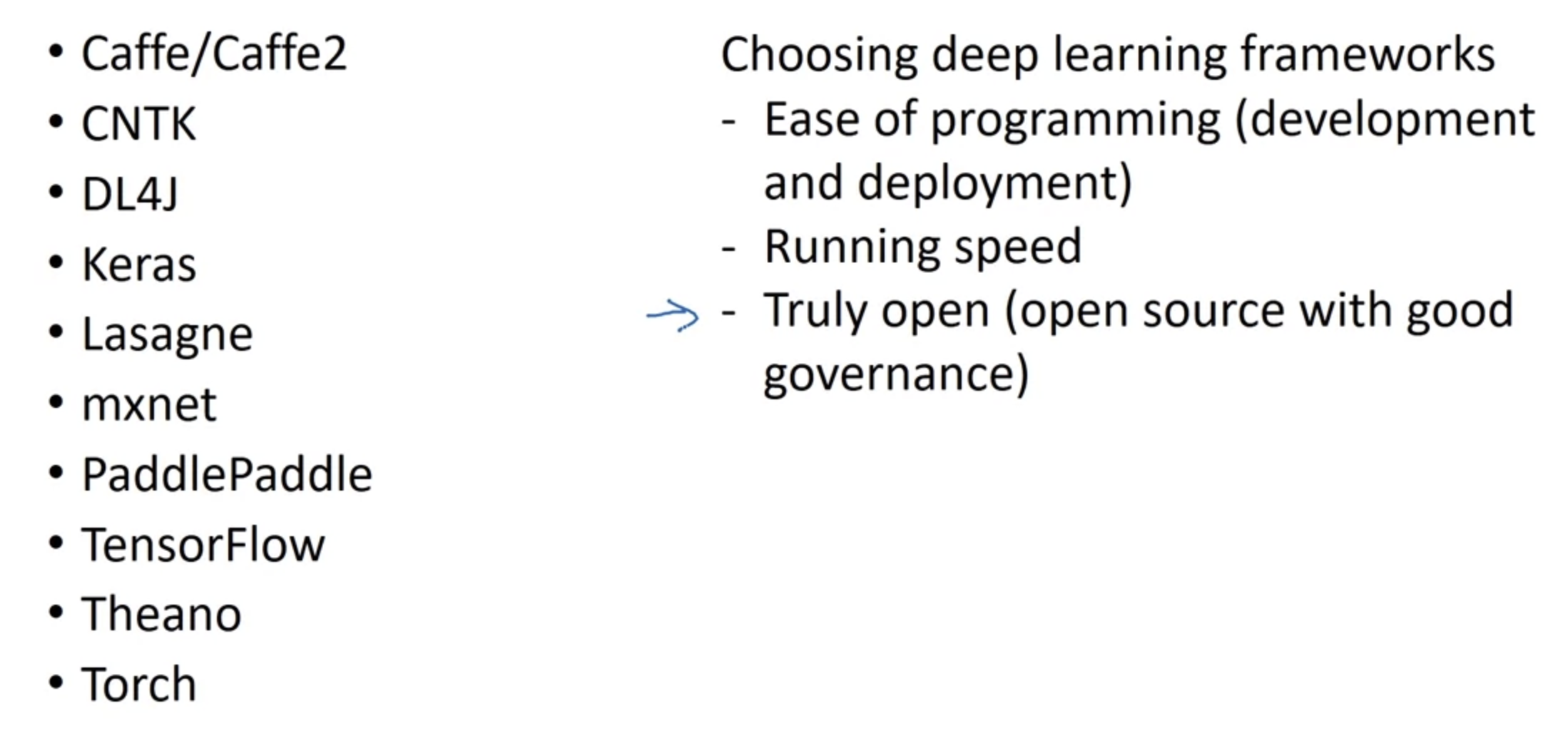

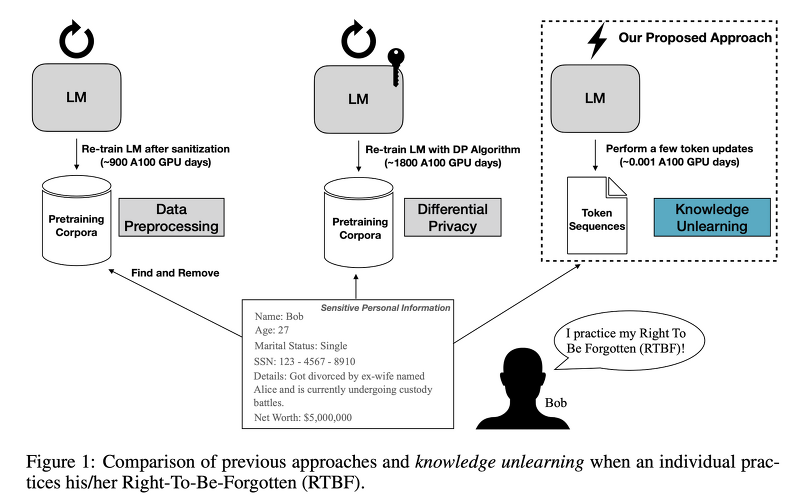

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [OpenAI] - strong pretrained model을 weak supervisor를 통해 fine-tuning 하더라도 supervisor보다 뛰어난 성능을 보인다 - 이를 weak-to-strong generalization 현상이라고 부른다 - 미래에는 superhuman model을 학습하기 위해 RLHF와 같은 테크닉들을 적용할 수 없을 것이다 1. Introduction 오늘날 많은 언어 모델들은 Reinforcement Learning from Human Feedback(RLHF)와 같은 테크닉들을 통해 학습되고 있습니다. ..

![[BOJ] 5430 : AC [구현/덱](Python) [BOJ] 5430 : AC [구현/덱](Python)](http://t1.daumcdn.net/tistory_admin/static/images/openGraph/opengraph.png)

![[대학원생 필수!] 논문 관리 프로그램 Zotero 추천 (WebDAV 연결, iPad annotation 싱크 관리) [대학원생 필수!] 논문 관리 프로그램 Zotero 추천 (WebDAV 연결, iPad annotation 싱크 관리)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FPMH6r%2FbtsFDFQmkcw%2FTkxkN9LcADufK8RWH2pBI0%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티