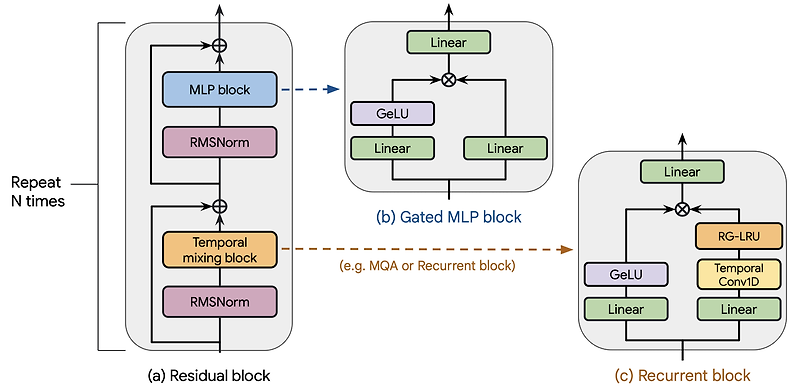

관심 있는 NLP 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [Google DeepMind] - RNN과 gated linear recurrence를 결합한 Hawk, gated linear recurrence와 local attention을 결합한 Griffin을 제안 - Hawk는 특정 태스크에서 Mamba 수준의 성능을, Griffin은 Llama-2 수준의 성능을 보임. 특히 후자의 경우 학습 당시에 접한 텍스트 보다 긴 데이터에 대해서도 뛰어난 성능을 보임. - 두 모델은 Transformers 대비 hardward efficient하며 lower latency & higher throughpu..

![[Short Paper Review] We're Afraid Language Models Aren't Modeling Ambiguity [Short Paper Review] We're Afraid Language Models Aren't Modeling Ambiguity](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FclTmUl%2FbtsfdW3X6Dj%2FBwU3WYMZruoxTUcWdFq391%2Fimg.png)

![<Attention> [TransNormer] Scaling TransNormer to 175 Billion Parameters <Attention> [TransNormer] Scaling TransNormer to 175 Billion Parameters](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FEIp1j%2FbtsqLRxcod5%2FLaDLhe5NNqul6P9eqD13L1%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티