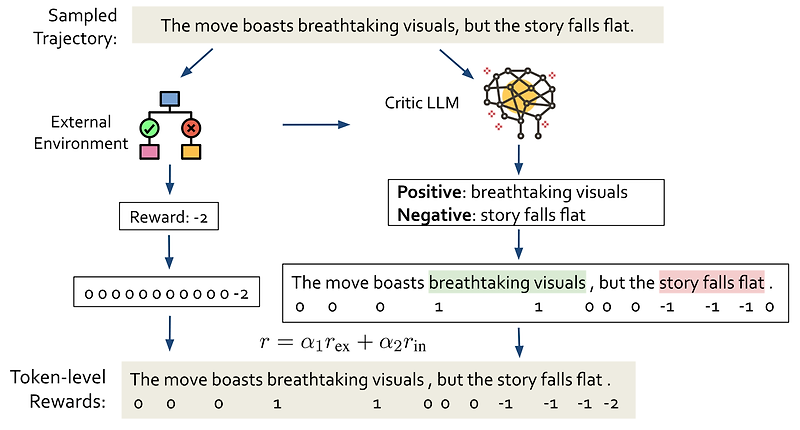

관심 있는 NLP 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 ️ usechatgpt init success [McGill University, University of Toronto, Mila, Google Research] - LLMs의 비판 능력을 활용하여 RL 학습 동안 intermediate-step rewards를 생성할 수 있도록 하는 프레임워크, RELC를 제안 - poicy model과 critic language model을 결합하는 method - critic language model로부터의 feedback은 token 또는 span 단위의 rewards로 전달됨 출처 : https://arxiv.org/abs/2401.07382..

![<LK Lab, Retrieval> [Np Decoding] Nonparametric Decoding for Generative Retrieval (2023.05) <LK Lab, Retrieval> [Np Decoding] Nonparametric Decoding for Generative Retrieval (2023.05)](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbMcvHV%2Fbtsz91K9PLV%2FDVBl5DWQhDXdX81n4lY8vK%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티