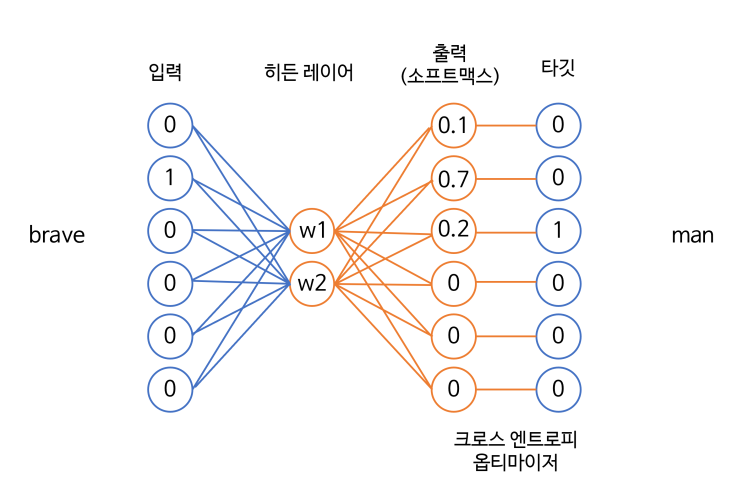

이번 포스팅에서는 자연어처리의 기본이 되는 단어 임베딩을 하는데 있어서 기초가 되는 모델인 Word2Vec에 대해서 정리해보겠습니다. ** 본 포스팅은 PC에 최적화 되어있으며, tensorflow 버전은 2.9.1, 작업환경은 colab입니다. ** **공부 참고 자료 - 허민석, 『나의 첫 머신러닝/ 딥러닝』, 위키북스, 2020. ** 들어가기 전에, 단어 인코딩이란? 딥러닝 모델은 입력을 수치값으로 받기 때문에 자연어처리 전처리 과정에서 단어를 수치로 변환해줘야 합니다. 이 과정을 인코딩이라고 합니다. 인코딩 방법에는 크게 정수 인코딩, 원 핫 인코딩, 임베딩이 있습니다. 정수 인코딩 단어를 빈도수 순으로 정렬한 단어 집합(vocabulary)을 만들고, 빈도수가 높은 순서대로 차례로 낮은 숫자부터 정수를 부여하는 방법 토큰 문서 내 토큰의 개수 정수 인코딩 사과 1 2 바나나 3 0 딸기 2 1 원 핫 인코딩 자연어처리에 가장 많이 사용되는 방법 각 단어에 고유한 인덱스를 ...

#NLP

#Tensorflow

#Word2Vec

#딥러닝

#딥러닝입문

원문링크 : Word2Vec 모델 구조 및 예제 :: 임베딩 결과 시각화 하기 + 단어 인코딩 방법 3가지

![[Python] 이코테 자료구조 : 우선순위 큐 & 힙](https://mblogthumb-phinf.pstatic.net/MjAyNDAzMjJfMTk5/MDAxNzExMDkxMTYwODA5.LNPsepXRmNf1cCPrhV7KGiJFbR5LV9DapALmevk8ICkg.Reav85oNkI5xpa-fW8BcozAme_1ENfFlnIvJh3JDFUIg.PNG/image.png?type=w2)

![[Python] 백준 골드5 12904번 A와 B (그리디)](https://mblogthumb-phinf.pstatic.net/MjAyNDAzMzFfMyAg/MDAxNzExODc5MjUyNDEy.2ePcjj8ZGzVtkZvrmnpuQMXNxzgxz--AGpFCItUUu3wg.fet-nskFQWZr76oK1am1lMqUP1tQNbpXp29F8hycgJ8g.PNG/image.png?type=w2)

![[코세라 머신러닝] 확률적 경사하강법 Stochastic Gradient Descent Convergence 수렴 여부 확인 학습률](https://mblogthumb-phinf.pstatic.net/MjAyMTAxMzFfMzgg/MDAxNjEyMDk1NjIxNDcx.PyxqPwjuZ0h9WzfcyUxJdDNTWZ5pde7nlM63ABMxYUwg.RfYCqmftf8vfmLqW3Rq5c0x20nAvO4fCzSPtq1cLmHYg.PNG.dbwjd516/coursera_machine_learning.png?type=w2)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티