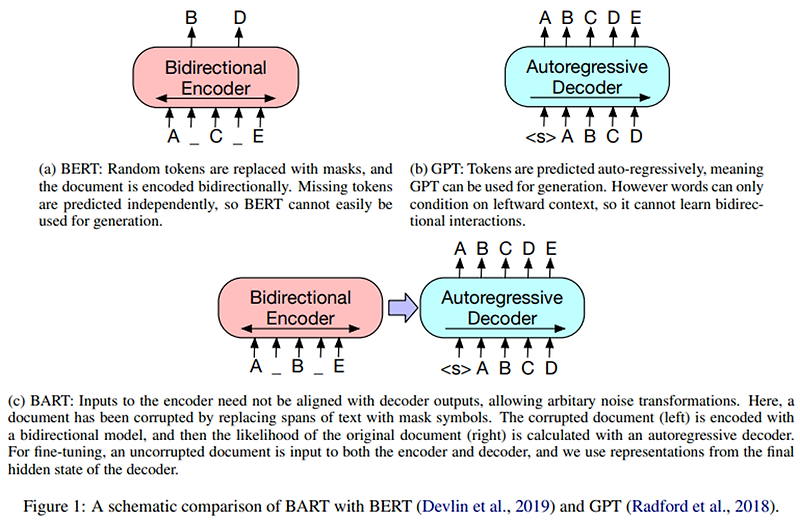

Abstract 이번 논문에서는 BART를 소개한다. BART는 seq2seq model을 pre-training시키는 denoising autoencoder이다. BART는 (1) 임의의 noising function으로 텍스트를 손상시키고, (2) original 텍스트를 재구..

BART: Denoising Sequence-to-Sequence Pre-training for NaturalLanguage Generation, Translation, and Comprehension에 대한 요약내용입니다.

자세한 내용은 아래에 원문링크를 확인해주시기 바랍니다.

![[Python] 4강 [Python] 4강](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FcVfk46%2Fbtrr16HasHf%2Fg7XLAQvgpZOQf70FXiFhE1%2Fimg.png)

![[MRC] 02. Extraction-based MRC [MRC] 02. Extraction-based MRC](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fcng0ta%2FbtrAvHrVn8R%2F4mry2881OLsF7OTKmiwGRk%2Fimg.png)

![[Python] 5강 [Python] 5강](http://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbUXt6t%2FbtrswUzfdAE%2FqfPnIMaCYzPaKlG26rPVvk%2Fimg.png)

네이버 블로그

네이버 블로그 티스토리

티스토리 커뮤니티

커뮤니티